Тяньхэ-2

Суперкомпьютер Tianhe-2 («Млечный путь»), а, точнее, уже дополненная и модернизированная версия 2А, была разработана сотрудниками компании Inspur и научно-технического университета Народно-освободительной армии Китая. В июле 2013 года модель считалась самой производительной в мире и уступила пальму первенства только другому китайскому компьютеру TaihuLight. На сборку ЭВМ потратили около 200 млн долларов.

Сначала вычислительная система находилась на территории университета, а затем была перемещена в суперкомпьютерный центр в Гуанчжоу. Общая площадь, которую она занимает – около 720 кв. м. Энергопотребление модели составляет 17,8 МВт, что делает ее использование менее выгодным по сравнению с более современными версиями.

Техника построена на базе 80 тысяч ЦПУ Intel Xeon и Xeon Phi. Объем оперативной памяти – 1400 Гбайт, количество вычислительных ядер – больше 3 миллионов. На суперкомпьютере установлена операционная система Kylin Linux. Первые показатели работы системы – 33,8 Пфлопс, современная модификация достигает скорости вычислений 61,4 Пфлопс, максимальная – 100,679 Пфлопс.

СуперЭВМ создали по требованию китайского правительства, его основными задачами являются расчеты для проектов национального масштаба. С помощью системы решаются вопросы безопасности Китая, выполняется моделирование и анализ большого количества научной информации.

Масштабность

Увеличение размеров суперкомпьютеров, может усугубить проблему в следующем десятилетии. Первый суперкомпьютер Cray-1 был размером с пару комнат, а современные серверы занимают площадь, равную футбольному полю. Поэтому учёные активно работают над дополнительными методами проверки ошибок, которые могут быть использованы по мере роста суперкомпьютеров. А в сфере беспилотных автомобилей много сил тратится на анализ точек отказа. То есть зон, где возникают критические неисправности в микросхемах GPU, способные вызвать аварии. Задача-минимум: предотвратить хотя бы ошибки в этих зонах.

Другой метод, используемый для проверки точности расчётов на суперкомпьютере, — это использование физики. В большинстве научных приложений есть некоторые константы, например, общая энергия системы должна быть постоянной. Поэтому время от времени можно проверять приложение, чтобы узнать, теряет ли система энергию или набирает её. Если это происходит, значит, что что-то идёт не так.

И Реч, и Баутиста-Гомес используют искусственный интеллект для создания систем, способных выявлять сбои. Паоло Реч работает с разработчиками ПО для проверки автономных транспортных средств, которое позволяет сравнивать последовательные изображения и выполнять «проверку чувствительности». На данный момент этот метод выявил 90% ошибок. Баутиста-Гомес использует машинное обучение для анализа выходных данных в режиме реального времени. «Например, если вы выполняете моделирование климата, эта система машинного обучения может анализировать давление и температуру моделирования. Глядя на эти данные, он узнает нормальные варианты, и когда у вас есть искажение данных, которое вызывает большие изменения, это может сигнализировать о том, что что-то не так». Такие системы пока широко не используются, но Баутиста-Гомес ожидает, что они понадобятся в будущем.

Суперкомпьютер — что это?

Когда вы покупаете персональный компьютер, в лучшем случае вы приобретаете ему компьютерный стол и выделяете место в комнате. Если представить, что вы покупаете суперкомпьютер, тогда ему понадобится большая комната, а, возможно, и целый этаж здания или здание целиком.

У каждого дома есть холодильник. Представьте, что «холодильник» — это всего одна вычислительная ячейка суперкомпьютера. Таких «холодильников» у суперкомпьютера может быть несколько десятков или сотен, при этом:

-

всех их нужно разместить в одной комнате;

-

все они соединены друг с другом и работают как единое целое, поэтому нужны будут километры кабелей;

-

они шумят при работе, поэтому нужно звукоизолировать комнату, где будет расположен суперкомпьютер;

-

они греются при работе, поэтому нужно продумать годную систему охлаждения, ведь воздушная система охлаждения не справляется, а потому подключают водяную систему охлаждения;

-

им нужно обеспечить бесперебойное электроснабжение, причем они потребляют очень много энергии;

-

и др.

То есть суперкомпьютер — это не монитор, клавиатура, мышка и системный блок, а это

-

большое количество аппаратных частей;

-

большая занимаемая площадь;

-

сопутствующие системы охлаждения и электропитания;

-

обслуживающий персонал;

-

и др.

Для чего нужен суперкомпьютер и такие мощные суперкомпьютерные системы? Этот вопрос многим не дает покоя, особенно пользователям, которые далеки от IT-сферы.

Суперкомпьютеры и их применение

Суперкомпьютеры — это супермощные компьютерные системы. Такие компьютеры решают сверхзадачи, которые обычный персональный компьютер будет решать десятки лет, а может, больше. Но самое интересное, что такие вычислительные задачи находятся вокруг каждого человека, например:

-

На них ведут расчеты химических формул лекарств, создавая новые фармакологические препараты. То есть можно смоделировать и предугадать, как будет воздействовать новое лекарство на ту или иную болезнь.

-

Они помогают моделировать ситуации, которые не создать экспериментальным путем. Например, при изучении космоса они могут смоделировать столкновение двух галактик, двух планет, астероида и планет, взрыв Солнца и др. Такие расчеты помогают лучше изучать космос и мир вокруг нас.

-

При проектировании различных технических устройств на суперкомпьютере можно моделировать ситуации из жизни, проводя эксперименты. Например, вы хотите создать новый автомобиль, и вас интересуют результаты его краш-теста. Не нужно создавать рабочий прототип автомобиля и разбивать его о стену. Такую ситуацию можно смоделировать на суперкомпьютере, не создав при этом ни одного реального прототипа автомобиля.

-

В военной промышленности больше не нужно постоянно проводить реальные испытания нового оружия. В процессе его создания можно моделировать разные реальные ситуации для оружия на суперкомпьютере. К примеру, при разработке бомб уже не нужно ничего взрывать на полигонах. Все делается в компьютере.

-

Частично суперкомпьютеры стали использовать при обучении искусственного интеллекта, особенно когда дело касается использования ИИ в научно-исследовательских трудах: метеорологии, медицине, генной инженерии, биоинженерии, прогнозировании чрезвычайных ситуаций, ядерной инженерии, химии и др.

-

Суперкомпьютеры способны моделировать реальность в виртуальном мире, поэтому когда сейчас говорят о масштабных метавселенных в виртуальной реальности, то подразумевают использование суперкомпьютеров для ее проектирования.

В общем, когда нужно создать симуляцию каких-то сложных ситуаций, на помощь приходят суперкомпьютеры. К примеру, все, наверное, смотрели или хотя бы слышали о фильме Аватар. Это фильм, который на протяжении всей картины использует крутую компьютерную графику. Однако мало кто знает, что создание компьютерной графики проводилось на суперкомпьютере. Ни один современный персональный компьютер не способен рассчитать графику для подобного фильма.

Технические характеристики

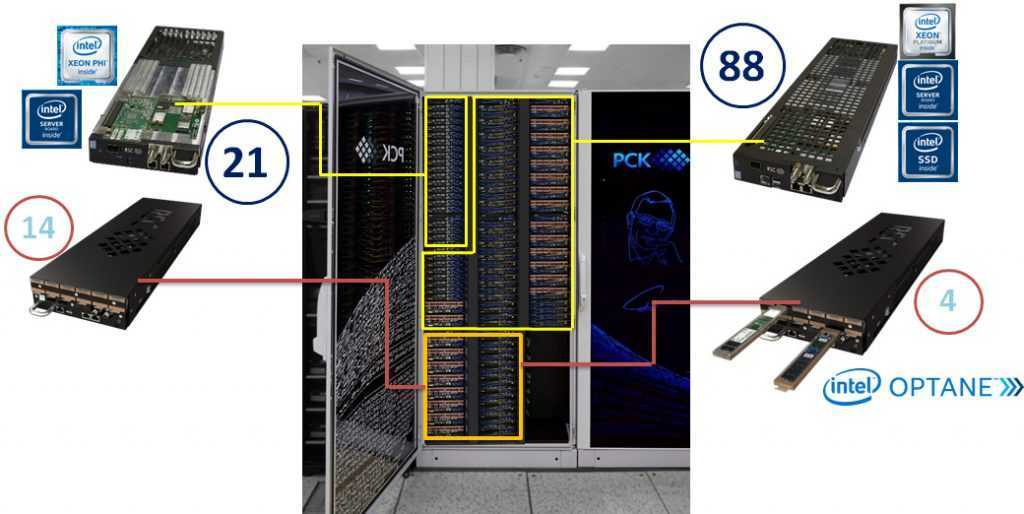

CPU компонента

Компания ЗАО «РСК Технологии» разработала обновленное сверхплотное, масштабируемое и энергоэффективное кластерное решение, которое представляет собой набор компонент для создания современных вычислительных систем различного масштаба с 100% жидкостным охлаждением в режиме «горячая вода». Оно включает высокопроизводительные вычислительные узлы на базе процессоров Intel Xeon Phi и Intel Skylake SP (Scalable Processor) в сочетании с высокоскоростным коммутатором Intel Omni-Path с аналогичным охлаждением «на горячей воде».

13 место в Top50 — 1070TFLOPS пиковой производительности с одинарной точностью

Характеристики

Характеристики

RSC Tornado nodes based on Intel Xeon Phi:

- Intel Xeon Phi 7190 processors (72 cores)

- Intel Server Board S7200AP

- IntelSSD DC S3520 (SATA, M.2)96GB DDR4 2400 GHz RAM

- Intel Omni-Path 100 Gb/s adapter

RSC Tornado nodes based on Intel Xeon Scalable gen 2 (TDN511):

- Intel Xeon Platinum 8268 processors (24 cores)

- Intel Server Board S2600BP

- Intel SSD DC S4510(SATA, M.2),2x Intel SSD DC P4511 (NVMe, M.2) 2TB

- 192GB DDR4 2933 GHz RAM

- Intel Omni-Path 100 Gb/s adapter

RSC Tornado nodes based on Intel Xeon Scalable gen 2 (TDN511S):

- Intel Xeon Platinum 8280 processors (28 cores)

- Intel Server Board S2600BP

- Intel SSD DC S4510(SATA, M.2),2x Intel SSD DC P4511 (NVMe, M.2) 2TB / 4x Intel (PMem) 450 GB

- 192GB DDR4 2933 GHz RAM

- Intel Omni-Path 100 Gb/s adapter

GPU компонента

NVIDIA DGX-1 – это первая система, разработанная специально для задач глубокого обучения. В основе системы лежит новое поколение графических процессоров, которые обеспечивают скорость обработки данных, сравнимую с 250 серверами x86 архитектуры.

ХарактеристикиВ состав HybriLIT входит 5 серверов DGX-1 с вычислительными процессорами двух типов:

-

-

- два процессора Intel Xeon E5-2698 v4 20 cores;

- восемь графических ускорителей NVIDIA Tesla V

-

со следующими аппаратными характеристиками:

| CPU | 80 cores |

| GPU | 8 cards |

| RAM | 512 GB |

| Storage | 7.6 TB |

| NVLink bandwidth | 300 GB/s |

| Ethernet | 10 Gbit/s |

| InfiniBand | 40 Gbit/s |

Заявленная производительность NVIDIA Tesla V100

| Double precision | 7.8 Tflops |

| Single precision | 15.7 Tflops |

| Deep learning | 125 Tflops |

Summit

Суперкомпьютер Summit, созданный американской компанией IBM для Национальной лаборатории в Окридже. Технику ввели в эксплуатацию летом 2018 года, заменив модель Titan, которая считалась самой производительной американской СуперЭВМ. Разработка лучшего современного суперкомпьютера обошлась американскому правительству в 200 млн долларов.

Устройство потребляет около 15 МВт электроэнергии – столько, сколько вырабатывает небольшая ГЭС. Для охлаждения вычислительной системы используется 15,1 кубометра циркулирующей по трубкам воды. Сервера IBM расположены на площади около 930 кв.м – территория, которую занимают 2 баскетбольные площадки. Для работы суперкомпьютера используется 220 км электрокабелей.

Производительность компьютера обеспечивается 9216 процессорами модели IBM POWER9 и 27648 графическими чипами Tesla V100 от Nvidia. Система получила целых 512 Гбайт оперативной и 250 Пбайт постоянной памяти (интерфейс 2,5 Тбайт/с). Максимальная скорость вычислений – 200 Пфлопс, а номинальная производительность – 143,5 Пфлопс.

По словам американских ученых, запуск в работу модели Summit позволил повысить вычислительные мощности в сфере энергетики, экономическую конкурентоспособность и национальную безопасность страны. Среди задач, которые будут решаться с помощью суперкомпьютера, отмечают поиск связи между раковыми заболеваниями и генами живого организма, исследование причин появления зависимости от наркотиков и климатическое моделирование для составления точных прогнозов погоды.

ImageMagick и OpenCL

Поддержка OpenCL появилась в ImageMagick уже достаточно давно, однако по умолчанию она не активирована ни в одном дистрибутиве. Поэтому нам придется собрать IM самостоятельно из исходников. Ничего сложного в этом нет, все необходимое уже есть в SDK, поэтому сборка не потребует установки каких-то дополнительных библиотек от nVidia или AMD. Итак, скачиваем/распаковываем архив с исходниками:

Далее устанавливаем инструменты сборки:

Запускаем конфигуратор и грепаем его вывод на предмет поддержки OpenCL:

Правильный результат работы команды должен выглядеть примерно так:

Словом «yes» должны быть отмечены либо первые три строки, либо вторые (или оба варианта сразу). Если это не так, значит, скорее всего, была неправильно инициализирована переменная C_INCLUDE_PATH. Если же словом «no» отмечена последняя строка, значит, дело в переменной LD_LIBRARY_PATH. Если все окей, запускаем процесс сборки/установки:

Проверяем, что ImageMagick действительно был скомпилирован с поддержкой OpenCL:

Теперь измерим полученный выигрыш в скорости. Разработчики ImageMagick рекомендуют использовать для этого фильтр convolve:

Некоторые другие операции, такие как ресайз, теперь тоже должны работать значительно быстрее, однако надеяться на то, что ImageMagick начнет обрабатывать графику с бешеной скоростью, не стоит. Пока еще очень малая часть пакета оптимизирована с помощью OpenCL.

Профилактические меры

Хотя вероятность подобных ошибок относительно низка, в некоторых критических системах используются меры избыточности за счёт удвоения или утроения каждого бита, так что ошибки могут быть обнаружены мгновенно. «Это особенно заметно в космических аппаратах и спутниках, которые не должны просто так выходить из строя», — утверждает ДеБарделебен. Но создание таких отказоустойчивых систем на суперкомпьютерах обходилось бы непомерно дорого, ведь на них часто выполняются программы, рассчитанные на месяцы работы. Вариант полной остановки нейтронов, достигающих этих машин, также непрактичен — требуется три метра бетона, чтобы заблокировать космические лучи. Хотя учёные рассматривали возможность размещения центров обработки данных глубоко под землей.

Современные суперкомпьютеры используют более совершенную ECC-память, которая автоматически распознаёт и исправляет спонтанно возникшие изменения (ошибки) битов памяти. Около 12% объёма записываемых данных используется для кодов исправления ошибок. Ещё одним важным нововведением для суперкомпьютеров является «контрольная точка» — процесс регулярного сохранения данных в середине вычисления. И если возникает сбой, вычисление может быть выполнено с последней контрольной точки. Вопрос лишь в том, как часто делать эти контрольные точки. Большая частота требует больших затрат времени и энергии, а малая чревата тем, можно потерять месяцы вычислительной работы.

Страх перед сбоем системы и потерей данных — это половина проблемы. Учёных беспокоит риск необнаруженных или скрытых ошибок. Тех, которые не вызывают сбоев и поэтому не обнаруживаются. По словам Баутисты-Гомеса, ECC обычно может обнаруживать одно- или двухбитовые перевороты, но «помимо этого, если у вас есть космический луч, который меняет три бита в ячейке памяти, то методы, которые мы используем сегодня, скорее всего, не смогут обнаружить это».

До недавнего времени не хватало прямых доказательств такого скрытого искажения данных в суперкомпьютерах, за исключением того, что Баутиста-Гомес описывает как «странные вещи, которые мы не знаем, как объяснить». В 2016 году вместе с ученым-компьютерщиком Саймоном Макинтош-Смитом из Бристольского университета он решил найти эти ошибки, используя специально разработанное сканирующее память ПО для анализа кластера из 1000 компьютерных узлов (точек данных) без какой-либо ECC. За год они обнаружили 55 000 ошибок памяти.

«Мы наблюдали много однобитовых ошибок, чего и следовало ожидать. Мы также видели множественные двузначные ошибки, а также несколько многобитовых ошибок, которые бы не заметили даже с ECC», — вспоминает Баутиста-Гомес.

Piz Daint

Суперкомпьютер Piz Daint достаточно долго (с 2013 до 2018 года) занимал третье место в рейтинге самых мощных вычислительных систем в мире. В то же время он остается самым производительным компьютером Европы. Стоимость проекта составила около 40 млн швейцарских франков.

Модель получила название в честь одноименной территории в Швейцарских Альпах и находится в национальном суперкомпьютерном центре. Оборудование, из которого состоит СуперЭВМ, располагается в 28 стойках. Для работы техники требуется 2,3 МВт электричества, и по этому показателю Piz Daint обеспечивает лучшую удельную производительность – 9,2 Пфлопс/МВт.

В составе ЭВМ есть другой суперкомпьютер Piz Dora, сначала работавший отдельно. После объединения мощностей швейцарские разработчики получили вычислительную систему с 362 тысячами ядер (процессоры Xeon E5-2690v3) номинальной производительностью 21,23 Пфлопс. Максимальная скорость работы – 27 Пфлопс.

Основные задачи суперкомпьютера – расчеты для исследований в области геофизики, метеорологии, физике и климатологии. Одно из приложений для ЭВМ, COSMO, представляет собой метеорологическую модель и используется метеослужбами Германии и Швейцарии для получения высокоточных прогнозов погоды.

Сеть

У меня пока не было потребности (ну или скажем так, мы всегда умудрялись оптимизировать свои расчеты), где нужно было бы соединять несколько нод для расчетов используя скажем DistributedDataParallel из PyTorch (на одной ноде все конечно прекрасно работает). Не могу оценить хватит ли для него «стандартных» 10 Gbit/s без установки дорогих сетевых карт на 40+ Gbit/s. Отдельный вопрос конечно что с этим делать, т.к. такая плата скорее всего займет еще один PCIE-слот.

Пока тут могу рассказать только про один хак — в «профессиональных» и «экстремальных» материнках зачастую бывает 1-2 разъема по 10 Gbit/s (и иногда даже третий гигабитный). В совсем дешевом варианте (только цена патч-корда высокой категории, но на коротком расстоянии даже «плохие» патч-корды показывают 10 гигабит) две такие материнки можно соеденить напрямую друг с другом и получить «суперкомпьютер». Если таких разъема два, то можно в мастер ноду уже воткнуть два патч-корда. Но чтобы соединить сеть больше, уже придется найти 10 гигабитный свич (внезапно найти подержанный Mikrotik не проблема, но они обычно очень сложны в настройке).

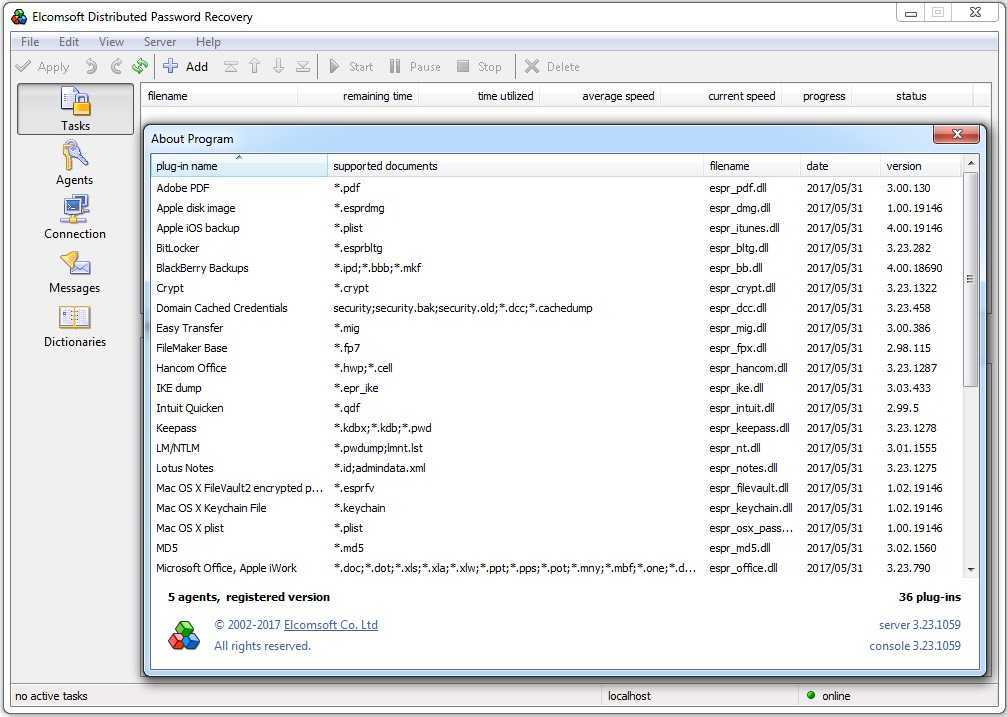

EDPR

Наверняка ты уже сталкивался с продуктами компании Elcomsoft. Помню, еще в начале нулевых я тестировал их первые «отмычки» для документов формата Microsoft Office, разных архивов и все думал, когда они выпустят универсальную программу. Ее появление не заставило долго ждать. Поначалу Elcomsoft Distributed Password Recovery (EDPR) просто вобрала в себя прежние наработки, но уже с 2008 года получила самостоятельное развитие. Тогда в нее добавили поддержку GPGPU и постепенно интегрировали все новые плагины, оптимизированные для использования видеокарт в брутфорсе. Последняя (на момент обзора) версия 3.23.1059 содержит 36 плагинов, знает около семидесяти форматов зашифрованных файлов и работает практически в любой версии Windows.

36 плагинов для взлома файлов большинства форматов

36 плагинов для взлома файлов большинства форматов

Запустить EDPR можно как в десктопных версиях Windows (от 32-битной XP до 64-разрядной «десятки»), так и в серверных. Однако для ее самой востребованной функции — аппаратного ускорения перебора паролей на видеокартах Nvidia — требуется Windows 7, 8, 8.1 или 10 либо Windows Server 2003, 2008 или 2012.

Теоретически EDPR может использовать для перебора паролей не только ГП от Nvidia, но и другие графические чипы с универсальной шейдерной архитектурой, выпущенные за последние семь лет. Это игровые видеокарты Nvidia, начиная с GeForce GTX 4xx и новее, AMD Radeon серий HD 5000 — HD 8000, более современные AMD R9 и RX. Поддерживаются также профессиональные видеокарты (все серии Nvidia Quadro и AMD FirePro) и специализированные решения обоих производителей. Последние, кстати, обеспечивают большую скорость перебора в расчете на каждый затраченный ватт энергии. Особенно энергоэффективны для своего техпроцесса оказываются Nvidia GeForce GTX Titan, Tesla K10 и выше, а также AMD Radeon Pro Duo, R9 Nano и R9 Fury X.

Однако для многих алгоритмов восстановления паролей используется не OpenCL, а CUDA-оптимизация. Поэтому ускоренная обработка некоторых форматов в EDPR возможна только с использованием ГП Nvidia. К таким форматам относятся архивы ZIP и RAR, документы PDF, хранилища паролей в macOS, пароли учетных записей в Windows, хеши MD5 и некоторые другие.

ЦП и ГП

Вне зависимости от формата зашифрованных файлов, видеокарты всегда используются как ускорители для легко распараллеливаемых операций, в то время как основной код программы исполняется на ЦП. Поэтому всегда требуется выделять одно ядро процессора на каждую задействованную видеокарту. Лучше, если это ядро будет физическим (а не выделенным через гиперпоточность). Процессорозависимость здесь тоже наблюдается, но умеренная. Очевидно, что современные ГП в полной мере не раскрываются даже топовыми ЦП, поскольку развитие последних идет преимущественно по пути увеличения исполнительных блоков (ядер), а не частот и объема кеша на ядро. Однако за пределами 3,5 ГГц и кеша L2 в 2 Мбайт у ЦП разница в производительности одной и той же видеокарты составляет считаные проценты при непропорционально больших затратах энергии. Поэтому, на мой взгляд, разумнее соблюдать баланс между стоимостью и общей производительностью системы, чем просто гнаться за максимальным быстродействием любой ценой.

О суперкомпьютере

27 марта в рамках сессии Комитета Полномочных Представителей правительств государств-членов ОИЯИ состоится презентация нового суперкомпьютера, названного в честь Николая Николаевича Говоруна, с именем которого с 1966 года связано развитие информационных технологий в ОИЯИ.

Суперкомпьютер «Говорун» — совместный проект Лаборатории теоретической физики им. Н.Н. Боголюбова и Лаборатории информационных технологий, поддержанный дирекцией ОИЯИ.

Проект нацелен на кардинальные ускорения комплексных теоретических и экспериментальных исследований в области ядерной физики и физики конденсированных сред, проводимых в ОИЯИ, в том числе для комплекса NICA.

Суперкомпьютер является естественным развитием гетерогенной платформы HybriLIT и приведет к существенному увеличению производительности как CPU, так и GPU-компонент платформы. Модернизированный вычислительный кластер позволит проводить ресурсоемкие, массивно-параллельные расчеты в решеточной квантовой хромодинамике для исследования свойств адронной материи при высокой плотности энергии и барионного заряда и в присутствии сверхсильных электромагнитных полей, качественно повысит оперативность моделирования динамики столкновений релятивистских тяжелых ионов, откроет новые возможности для исследования свойств сильно-коррелированных систем в области физики новых материалов, а также позволит разрабатывать и адаптировать программное обеспечение для мега-проекта NICA на новые вычислительные архитектуры от основных лидеров рынка HPC – Intel и NVIDIA, создать программно-аппаратную среду на базе HPC и готовить IT-специалистов по всем необходимым направлениям.

Расширение CPU-компоненты осуществлено на базе специализированной для HPC инженерной инфраструктуре на технологии контактного жидкостного охлаждения, реализуемой российской компанией ЗАО «РСК Технологии». Эта компания является лидером на российском рынке в области HPC-решений на жидкостном охлаждении, которые базируются на ряде собственных уникальных разработок, позволяющих создавать сверхкомпактные и энергоэффективные HPC-системы с высокой вычислительной плотностью. Расширение GPU-компоненты осуществлено на базе вычислительных серверов последнего поколения с графическими ускорителями NVIDIA Volta. Поставку оборудования и пуско-наладочные работы в рамках создания кластера с GPU-компонентой на базе NVIDIA выполнил системный интегратор IBS Platformix.

Назначение суперкомпьютеров

Суперкомпьютеры решают разнообразные задачи – от сложных математических расчетов и обработки огромных массивов данных до моделирования искусственного интеллекта. Есть модели, воспроизводящие «архитектуру» человеческого мозга. На СуперЭВМ проектируют промышленное оборудование и электронику, синтезируют новые материалы и делают научные открытия.

Автомобилестроительные компании используют суперкомпьютеры для имитации результатов краш-тестов, экономя средства на настоящих испытаниях. Подходит такая мощная техника и для разработки новых двигателей, позволяя моделировать специальный температурный режим и процессы деформации. С ее же помощью можно прогнозировать метеорологические явления и даже землетрясения.

Космический хаос

Космическое излучение идёт от Солнца и от разнообразных космических происшествий наподобие взрыва сверхновой в нашей галактике или за её пределами. Космические лучи состоят в основном из высокоэнергетических протонов и ядер гелия, которые движутся в пространстве почти со скоростью света). Космическое излучение в основном состоит из заряженных частиц: протонов (88%), ядер гелия (9%), антипротонов, электронов, позитронов и нейтральных частиц, которые движутся в космосе почти со скоростью света. Когда они сталкиваются с атмосферой Земли, то создают вторичный поток частиц, включая нейтроны, мюоны, пионы и альфа-частицы.

«Доходят до поверхности земли в основном быстрые нейтроны», — объясняет Кристофер Фрост, который управляет устройством ChipIR в лаборатории Резерфорда Эпплтона в Великобритании. Оно было создано в 2009 году для изучения последствий облучения микроэлектроники.

Экспресс-тестирование эффектов единичного события. Схема компонентов, необходимых для создания пучка атмосферных нейтронов ChipIr.

Учёный-компьютерщик Леонардо Баутиста-Гомес из Суперкомпьютерного центра Барселоны сравнивает эти ошибки с мутациями, которые иногда происходят в ДНК человека. «В зависимости от того, где происходит мутация, она может стать или не стать причиной появления рака, и это очень похоже на компьютерный код».

Кристофер Фрост вместе с ученым Паоло Речем из бразильского Федерального университета Риу-Гранди-ду-Сол также изучал дополнительный источник осложнений в виде медленных нейтронов. Эти нейтроны имеют на девять порядков меньше энергии, чем у их собратьев из космических лучей. Тепловые нейтроны могут быть особенно «вредными», когда они сталкиваются с бором-10, который содержится во многих полупроводниковых чипах. Ядро бора-10 захватывает нейтрон, распадаясь на литий и альфа-частицу.

Эксперты из Frost and Rech протестировали шесть имеющихся в продаже устройств, запустили их в нормальных условиях, и обнаружили, что все они подвергались воздействию медленных нейтронов (J. Supercomput. 77 1612). «В принципе, чтобы избавиться от этой проблемы, можно использовать чрезвычайно чистый бор-11», — считает Паоло Реч, но добавляет, что это увеличивает стоимость производства. Ведь даже суперкомпьютеры используют готовые коммерческие компоненты, которые могут пострадать от тепловых нейтронов. Хотя космические лучи есть везде, образование тепловых нейтронов чувствительно к окружающей среде устройства.

«Вещества, содержащие водород , или предметы, сделанные из бетона, тормозят быстрые нейтроны, превращая их в медленные», — объясняет Фрост. Исследователи даже обнаружили, что погода влияет на количество тепловых нейтронов, их уровень в дождливые дни увеличивается вдвое.

Универсальная открывашка

В дистрибутив EDPR входят серверная часть, локальный агент и консоль управления. Основная работа по восстановлению паролей начинается с запуска EDPR Console. В этой консоли можно выбрать зашифрованные файлы и тип перебора паролей:

- по словарю;

- по маске;

- полный брутфорс.

Отдельно для атаки по словарю можно задать мутации: использование цифр, знаков пунктуации, смену регистра и так далее. Поэтому EDPR способен определить не только словарный вариант пароля, вроде , но и разные его модификации, вроде или .

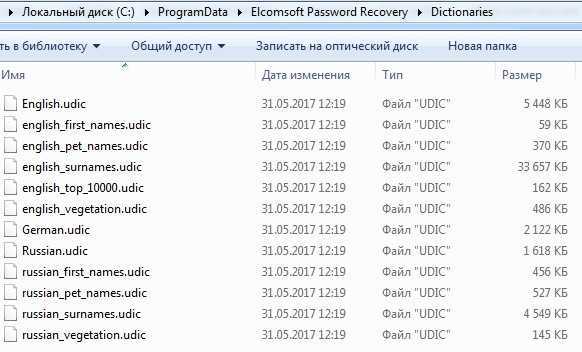

Словарь можно указать любой или создать свой, но в составе EDPR уже есть целый набор отличных словарей: пять для английского языка, четыре для русского и один для немецкого.

Набор предустановленных словарей в EDPR

Набор предустановленных словарей в EDPR

Дополнительно для алгоритмов шифрования с известной слабиной вместо перебора паролей в EDPR появляется опция подбора непосредственно ключа. Это в разы быстрее.

С атакой по маске все просто — если тебе известны какие-то символы пароля, например ты подсмотрел, что он начинается с , то просто вписываешь вместо первого символа маски (знака вопроса). Знаешь другие символы? Отлично! Заполняй их тоже.

Брутфорс в EDPR также максимально облегчен. Все символы разбиты на пять основных групп (строчные буквы, прописные буквы, цифры, знаки препинания и пробел), а частые сочетания (например, строчные буквы и цифры) можно задавать как отдельные группы и выбирать их из пресета. Для всех перебираемых паролей можно указать не только максимальную длину, но и минимальную. Это удобно, если ты твердо знаешь, что пароли с длиной менее N технически невозможно использовать в какой-то анализируемой системе.

На вкладке «Комментарий» можно посмотреть все данные о зашифрованном файле. Например, для тестового архива RAR старого формата указывается версия (RAR 3-4), алгоритм шифрования (AES) длина ключа (128 бит) и версия плагина, которым непосредственно выполняется перебор паролей (espr_rar.dll v.3.22.109). Там же можно увидеть дату и время создания задачи по выполнению аудита.

Вариант 1. Присоединись к сообществу «Xakep.ru», чтобы читать все материалы на сайте

Членство в сообществе в течение указанного срока откроет тебе доступ ко ВСЕМ материалам «Хакера», позволит скачивать выпуски в PDF, отключит рекламу на сайте и увеличит личную накопительную скидку!

Подробнее

Вариант 2. Открой один материал

Заинтересовала статья, но нет возможности стать членом клуба «Xakep.ru»? Тогда этот вариант для тебя!

Обрати внимание: этот способ подходит только для статей, опубликованных более двух месяцев назад.

Я уже участник «Xakep.ru»

Квантовая головоломка

Если заглянуть в будущее, где вычисления, скорее всего, будут квантовыми, то становится понятно, как усложнят нашу жизнь космические лучи. Базовая единица квантовой информации, кубит, может существовать в трех состояниях: 0, 1 и смешанном, что обеспечивает параллельные вычисления и возможность выполнять расчёты, слишком сложные даже для современных суперкомпьютеров. Чтобы квантовые компьютеры функционировали, кубиты должны быть когерентными — это означает, что они действуют вместе с другими битами в квантовом состоянии. Сегодня самый длительный период когерентности для квантового компьютера составляет около 200 микросекунд.

Ученые изучали, как космические лучи могут вызвать декогеренцию кубитов, что является проблемой для квантовых вычислений.

Учёные Формаджо и Уильям Оливер из Массачусетского технологического института провели эксперимент с использованием радиоактивной медной фольги, производящей изотоп меди-64, распадающейся с периодом полураспада чуть более 12 часов. Они поместили её в холодильник с охлаждённым до жидкообразного состояния 3He и 4He со сверхпроводящими кубитами Оливера. «Сначала мы включал свой прибор, и ничего не работало», — описывает Формаджо, «но через несколько дней, появилась возможность зафиксировать хоть что-то , потому что радиоактивность снижалась. Мы делали это в течение нескольких недель и могли наблюдать, как кубит медленно возвращается к исходному состоянию». Исследователи также продемонстрировали эффект, создав массивную двухтонную стену из свинцовых кирпичей, которую они поднимали и опускали для защиты кубитов каждые 10 минут, и увидели, как меняется стабильность кубитов.

На основе этих экспериментов они предсказали, что космическое и другое внешнее излучение ограничивает когерентность кубита максимум до 4 миллисекунд (Nature 584 551). Проблема пока ещё не является серьёзной, но по мере увеличения времени когерентности радиационные эффекты станут более значительными.

Конечно, как и в случае с суперкомпьютерами, сообщество учёных ищет способ обойти эту проблему. Google предложил добавить островки из алюминиевой пленки в свой 53-кубитный квантовый процессор Sycamore. Кубиты сделаны из гранулированного алюминия, сверхпроводящего материала, содержащего смесь наноразмерных зерен алюминия и аморфного оксида алюминия. Они сидят на кремниевой подложке, и когда на неё воздействует излучение, происходит обмен фотонами между кубитом и подложкой, что приводит к декогеренции. Есть надежда, что островки алюминия будут улавливать фотоны.

Другое решение, предложенное Google, — это специальный код квантовой коррекции ошибок, называемый «поверхностным кодом». Google разработал шахматную доску расположения кубитов, где «белые квадраты» представляют кубиты данных, которые выполняют операции, а «черные квадраты» выявляют ошибки в соседних кубитах. Расположение позволяет избежать декогеренции, полагаясь на квантовую запутанность квадратов.

Задача на ближайшие несколько лет — найти способ повысить устойчивость суперкомпьютерных технологий. Возможно, что ошибки, вызванные космическим излучением, могут стать препятствием для более быстрых суперкомпьютеров, даже если размер компонентов будет уменьшаться.

Что ещё интересного есть в блоге Cloud4Y

→ Изучаем своё железо: сброс паролей BIOS на ноутбуках

→ Реклама в Windows 11 сломала «Пуск» и панель задач некоторых пользователей

→ Клавиатуры, которые постигла неудача

→ Мониторинг СУБД VMware Cloud Director и vCenter Server Appliance с помощью Zabbix

→ Из кузова грузовика в сумочку: самые известные портативные компьютеры

Подписывайтесь на наш Telegram-канал, чтобы не пропустить очередную статью. Пишем не чаще двух раз в неделю и только по делу.

Sunway TaihuLight

Китайская СуперЭВМ удерживала лидирующую позицию в рейтинге TOP500 с 2016 до 2018 года. В соответствии с тестами LINPACK ее считали самым производительным суперкомпьютером, минимум в полтора раза превосходящим ближайшего конкурента и втрое опережающим самую производительную американскую модель Titan. Разработка и строительство вычислительной системы обошлось в 1,8 млрд. юаней или 270 млн долларов. Инвесторами проекта были правительство Китая, администрация китайской провинции Цзянсу и города Уси.

Суперкомпьютер потребляет 15,3 МВт электроэнергии и занимает площадь 605 кв.м. Расположен он на территории города Уси, в национальном суперкомпьютерном центре. Название модели дали в честь расположенного рядом озера Тайху, третьего по величине пресноводного водоема Китая.

Наличие в конструкции ЭВМ 41 тысячи процессоров SW26010 и 10,6 миллиона ядер позволяет ей проводить расчеты со скоростью 93 Пфлопс. Максимальная производительность – 125 Пфлопс. Переход на чипы китайского производства потребовал от разработчиков создания полностью новой системы. До этого предполагалось в 2 раза повысить производительность другой китайской СуперЭВМ Тяньхэ-2, но эти намерения пришлось изменить из-за проблем с поставками процессоров Intel из США.

Модель Sunway TaihuLight применяется для выполнения сложных вычислений в области медицины, горнодобывающей промышленности и производстве. С помощью вычислительной машины прогнозируют погоду, исследуют новые лекарства и анализируют «большие данные» – массивы информации, обработать которые не получится даже у самого мощного серийного компьютера.