Анализ данных и вовлечение сотрудников

Правильная работа документами

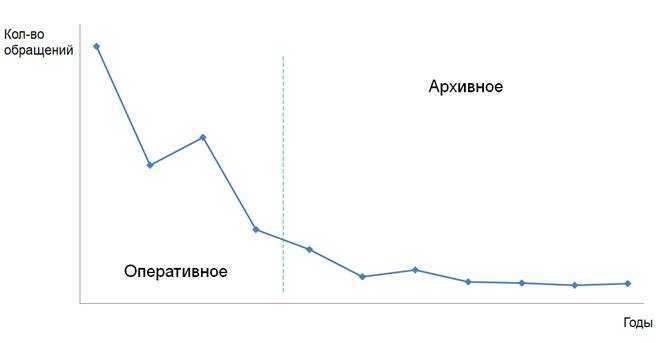

Можно оценивать частоту работы с документами для принятия

решений об их автоматическом переносе в архив, смене прав доступа. Или даже для

формирования подборок документов, подходящих для определенного круга

сотрудников для текущей работы.

Число обращений

к документу, описывающему технологии и процессы

Пример с документом, описывающим процедуру работы в

компании. Мы видим, что в период появления документа большое количество

сотрудников массово его просматривали. С течением времени поток обращений

снизился и зафиксировался на уровне только новичков (т.к. базовым технологиям

текущие сотрудники уже привыкли следовать). На основе такой статистики система

сама может сделать вывод о необходимости переноса документа в архивное

хранилище, а также включение его в список обязательных документов для всех

новичков.

Профиль загрузки сотрудников

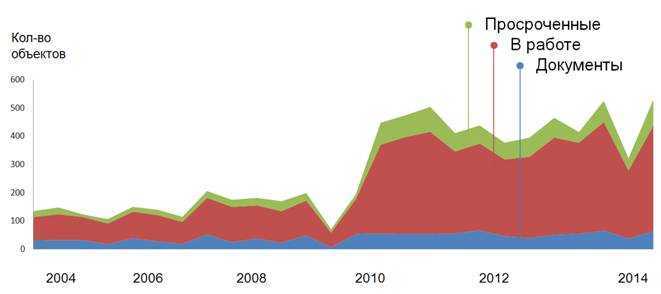

Система сама может оценить профиль загрузки сотрудника, в

том числе статистику работы с документами и выполнения заданий, может посылать

сигналы о необходимости гармонизации загрузки, перераспределения процессов на

коллег.

Статистика о

работах и загрузке сотрудника в ECM-системе

Например, из данных графика система может понять, что в

2009 году сотрудник перешел на руководящую должность, отметив, что его профиль

работы сменился, что он стал выполнять больше «быстрых» заданий, вероятно, и больше

делегировать. Но при этом процент просроченных остался неизменным, но с учетом

роста количества задач, количество просроченных стало угрожающим. Вероятно,

отследив это средствами системы, стоит просигнализировать сотруднику о факте неприемлемого

роста количества просроченных заданий.

Что такое цикл зрелости технологий – Hype Cycle от Gartner

Прежде всего поясним, что такое компания Gartner и почему ее прогнозы так высоко ценятся. Основанная в США еще 1979 году, она специализируется на консалтинге и аналитических исследованиях в ИТ. В частности, именно Gartner ввела в широкое употребление понятие ERP (enterprise resource planning) как развитие концепции планирования производственных ресурсов MRP II (manufacturing resource planning). Кроме того, каждый год Gartner публикует аналитический отчет о технологиях, наиболее востребованных сегодня и в ближайшем будущем .

Как правило, в прогнозах Gartner степень востребованности технологии определяется ее позицией на графике, который получил название «цикл зрелости» (Hype Cycle). Этот инструмент оценки был впервые предложен в 1995 году и до сих пор активно используется для анализа рынков. Согласно концепции Hype Cycle: каждая инновация (технология, методология, инструментальная система и пр.) в течении своей жизни проходит несколько этапов, каждый из которых характеризуется различной степенью интереса со стороны общества и специалистов :

- старт (запуск) или технологический триггер (technology trigger), когда об инновации только появляются первые публикации в СМИ;

- ажиотаж или пик чрезмерных ожиданий (Peak of Inflated Expectation), когда от новой технологии ожидают революционных свойств, а ее новизна провоцирует рост популярности и делает ее предметом широкого обсуждения в сообществе;

- разочарование или избавление от иллюзий (Trough of Disillusionment), когда выявляются главные недостатки технологии, которая теряет новизну и многочисленные восторги общества;

- работа над ошибками или преодоление недостатков (Slope of Enlightenment), когда найдены способы устранения основных недостатков, общество снова интересуется технологией, которая начинает применяться в коммерческих проектах;

- эффективное использование или плато продуктивности (Plateau of Productivity), когда общество воспринимает зрелую технологию как данность, объективно оценивая её возможности, достоинства и ограничения.

Разумеется, в реальности далеко не все технологии достигают зрелости, преждевременно завершая свой жизненный цикл без перспектив эффективного использования. Обычно в своих аналитических отчетах для конкретного сегмента рынка Gartner показывает место каждой новой технологии на графике ее развития, а также прогнозируют ее возможность стать зрелой и широко применяемой на практике .

Цикл технологической зрелости — Hype Cycle от Gartner

Приведем несколько примеров, как задачи, которые нужно решить бизнесу, ведут к использованию BigData в HR

Кейс 1. Компания по производству и продаже вентиляционного оборудования вкладывала большие деньги в развитие своих менеджеров по продажам. Один сотрудник проходил тренинг минимум раз в три месяца. В то же время, данные по продажам по сравнению с конкурентами не радовали. Для выявления причины, был проведен анализ ключевых показателей (KPI) руководителей на основе прибыльности и убыточности их подразделений; обратной связи от клиентов и показателей эффективности сотрудников, влияющих на бизнес-результат и их мотивацию. В результате образовалась видная прямая зависимость между слабым взаимодействием с клиентами и неэффективным управлением сотрудниками подразделения. То есть проблема была не в продавцах, а в их руководителях. Также сменился контингент клиентов, подходы остались прежними. После этого были приняты управленческие решения по изменению некоторых руководящих лиц, а для других была в обязательном порядке запланирована коучинг- сессия и система развития

BigData помогла избавиться от субъективного мнения о развитии сотрудников, направив средства и внимание руководства на ключевые факторы, влияющие на прибыль

Кейс 2.Компания, работающая в сфере образовательных услуг, несколько раз уже попадала в ситуацию, когда обученные сотрудники, которые состояли в кадровом резерве, внезапно уходили. Это серьезно подрывало имидж, и сказывалось на доходах.

С применением технологий BigData, был разработан инструмент удержания, который анализирует целый ряд различных типов данных (образование, место работы, семейное положение, опыт и достижения, тип работы, длина проектов, проектные достижения за последний год, продвижение по службе или его отсутствие). На основе полученных данных был выстроен алгоритм, который выделял людей, находящихся в зоне риска.

Ежемесячно руководители и HR служба получали данные о сотрудниках находящихся в зоне риска (это означало, что они профессионально выгорают, не мотивированы, могут планировать уход из компании), чтобы можно было принять меры по удержанию, мотивации, вовлечению сотрудника. Это позволило снизить общую текучку персонала и добиться того, что из нее уходило не более 2-3 резервистов в год. Фактически, BigData стала инструментом для мониторинга текущего состояния и прогнозирования будущих рисков.

Кейс 3. Компания занимается поставной и установкой сложного оборудования в сфере энергетики. Затраты на 200 менеджеров проекта составляли более 800 миллионов рублей в год, но их стоимость не соответствовала качеству выполняемой ими работы. Генеральный директор предполагал, что промышленность не привлекательна для хороших проектных менеджеров. И поэтому сосредотачивался на других методах повышения прибыльности.

Был проведен анализ эффективности родителей проекта, их опыта, уровня развития компетенций. В результате стало ясно, что нацеленность на результат была у менеджера более важна, чем технические навыки и опыт работы в отрасли. На ключевые проекты были подобраны лучшие кандидаты по новым критериям, им было проведено обучения специфике бизнеса и технологиям, используемым Компанией. Доход Компании увеличился благодаря замене процессных людей на результативных и их обучению предметной области отрасли. Очень многое зависит от правильно заданного вопроса. Он должен касаться не какой-то функции, а конкретной проблемы. В данной ситуации этим вопросом было: «Как мне привлечь эффективный персонал?». Если бы Генеральный директора сразу бы его задал, то не потерял бы 5 лет на неэффективном подборе.

Что мешает дальнейшему развитию

Технические проблемы, связанные с использованием решений Big Data, в течение последних лет удалось полностью устранить. Задачи, для решения которых недостаточно текущего набора технологий, встречаются крайне редко. Тем не менее, есть несколько факторов, замедляющих развитие big data.

Часто бизнес-процессы в компании недостаточно отлажены для применения новых технологий. Разные отделы компаний создают аналитические хранилища для своих нужд, данные в этих хранилищах оказываются рассогласованными и в результате, когда появляется необходимость решать более масштабные аналитические задачи, интеграция данных из разных источников оказывается сильно затруднена — требуется переход на общий стек технологий и кропотливая совместная работа аналитиков. Таких ситуаций можно избежать, если изначально ответственно подходить к хранению данных — стремиться к централизации, так называемой «единой версии правды».

Психологической преградой к внедрению Big Data до сих пор является мнимая дороговизна таких решений. При словах большие данные в голове возникает картинка дата-центра со стройными рядами серверов астрономической стоимости. На самом деле, сейчас существует большое количество платформ, предоставляющих виртуальные вычислительные ресурсы. Самые масштабные из них — такие как Amazon Web Services и Microsoft Azure — берут на себя практически все управление кластерами клиентов.

С точки зрения разработки ПО для Big Data ситуация также очень изменилась за последние три года. Многие open source проекты перешли из стадии тестирования в стабильные релизные версии, технологии виртуализации и контейнеризации позволяют разворачивать приложения любой сложности на кластерах любых конфигураций. На рынке появляется все больше специалистов, готовых работать с этими технологиями.

О цифровой платформе для промышленной аналитики

Цифровая платформа

Цифровая платформа

Преимуществом использования единой цифровой платформы является возможность организации работы цифровых сервисов предприятия в одном месте.

На базе цифровой платформы, содержащей все данные компании, можно:

Благодаря использованию Greenplum со стандартным интерфейсом для создания точки доступа можно достаточно быстро и легко подключаться и получать данные. Помимо единой точки доступа к цифровым сервисам и данным цифровая платформа также обеспечивает:

-

Интеграцию и сбор данных. Наши 2 фреймворка включают модули, которые позволяют проще интегрироваться с внешними источниками, как реляционными, так и потоковыми.

-

Стандартный паттерн обработки интеграционных сценариев и стандартный механизм сбора и обработки данных (потоковых и непотоковых), что позволяет быстро реализовать стандартный сценарий. Например, в рамках проекта в промышленности мы можем быстро создать аналитические витрины по контролю отклонений и по расчету определенных показателей.

-

Аналитику данных (BI) и, соответственно, возможность использования решений для бизнес-аналитики — Tableau, Power BI или российские аналоги.

-

Возможность подключения цифровых инструментов и разработки математических моделей после проведения бизнес-аналитики и обеспечения доступа к данным, а также подключение дополнительных сервисов, в том числе силами заказчика.

Цифровая платформа обеспечивает для предприятия:

-

Единое хранилище данных, доступное для анализа и моделирования (прогнозирования). Благодаря цифровой платформе можно проводить натурные эксперименты с данными и проверять бизнес-гипотезы. Например, можно моделировать события в случае остановки оборудования или снижения продаж и находить другие технологические и прочие параметры для тех или иных бизнес-процессов.

-

Удобную платформу для сбора и анализа разнородной информации (временных рядов, реляционных данных, неструктурированной информации), в том числе с системами видеоаналитики, логирования и т. д. для аудита событий безопасности.

-

Оптимизацию и повышение прозрачности бизнес-процессов.

-

Выявление тенденций за счет использования технологий искусственного интеллекта и машинного обучения.

-

Снижение нагрузки на учетные системы и системы управления. Например, при разработке математической модели для определенного подразделения, в модели скорее всего будут использоваться данные из той или иной системы, например, АСУ ТП, что увеличивает нежелательную нагрузку на такие системы. Благодаря горизонтальному масштабированию наша платформа обеспечивает распределение нагрузки на кластер.

Предоставляем платформу для работы с big data

Получите все преимущества аналитики больших данных с меньшими затратами сил, времени и средств

Узнать больше

«Цифровой след» сотрудника

Еще одна интересная гипотеза – это отслеживание «цифрового

следа» сотрудника, оставленного при работе с различными массивами данных,

взаимодействии с коллегами, прочей рабочей активности. На его основе могут

выявляться поведенческие гипотезы, которые позволят повысить удобство

взаимодействия пользователя с системой, окружением (другими системами, коллегами).

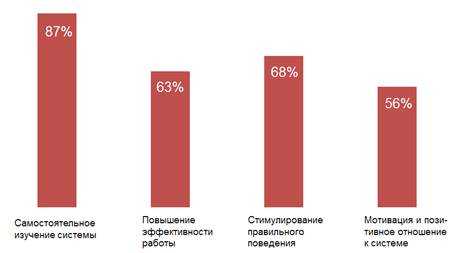

Игровые механики

Внедрение в корпоративное окружение элементов игры может

стать инструментом анализа поведения пользователей, стимулирования правильного

использования функций системы и глубокого их изучения, следования технологиям компании

и повышения эффективности.

Элементы геймификации, внедренные в нашей компании,

подтвердили предположения о том, что новый подход становится стимулом для

сотрудников. Мы также выявили неожиданный факт, что основными участниками стали

не молодые сотрудники, а опытные, в возрасте за 30 лет, а также топ-менеджмент,

который нашел в игре новый элемент поиска активных сотрудников и оценки их эффективности.

Процент

сотрудников, отметивших конкретные плюсы геймификации

Социализация

Другим механизмом вовлечения может стать пересмотр

принципов работы сотрудников в корпоративных системах – от контента к

взаимодействую внутри рабочих групп. Формирование кругов по интересам (отделы,

крупные проекты, рабочие группы, профессиональные клубы и гильдии), получение

информации от коллег, формирование профессиональных дайджестов, внутренних

чатов – все это инструменты, которые могут помочь в вовлечении сотрудников и

повышении эффективности их работы.

Поиски закономерностей внутри работы плотно

взаимодействующих групп, быстрая передача им полномочий и информации,

закрепление результата, неформальная субординация, принципы хранения и

использования данных – все это становится возможным при включении социальных

механизмов в корпоративную среду.

И, если речь идет о крупной компании, имеющей в штате

тысячи сотрудников, накопление корпоративной статистики и ее анализ должны как

можно быстрее переходить от гипотез к реальным шагам.

Коротко о главном

- Большие данные — это наборы данных, которые быстро генерируются и поступают из разных источников. Потом эту информацию можно использовать, чтобы составлять прогнозы, статистику, принимать бизнес-решения.

- Есть шесть основных характеристик больших данных: скорость накопления данных, объем, разнообразие, достоверность, изменчивость и ценность.

- Данные в основном поступают из трех источников: социальных (соцсети, приложения, онлайн-сервисы), машинных (оборудование, элементы «умного» дома), транзакционных (финансовые транзакции).

- Данные хранятся в data-центрах с мощными серверами. Обрабатывают данные в распределенных системах хранения данных.

- Для анализа big data используют описательную, диагностическую, прогнозную и предписательную аналитику.

- Большие данные используют в бизнесе, банковской сфере, ретейле, маркетинге, госструктурах, логистике, автомобилестроении, медицине.

- У big data большие перспективы, но есть и сложности: для хранения данных нужна инфраструктура, которая может дорого стоить. Еще, чтобы работать с большими данными, нужно хорошо разбираться в предметной области, а не только в технической части.

*Площадки Meta признаны экстремистскими и запрещены в РФ.

Что будет с HR и BigData

В ближайшие несколько лет у компаний, где есть развитые информационные системы, начнут проводить анализ данных и искать взаимосвязи. Открывшиеся возможности дадут серьезный прирост эффективности. Появятся также вакансии в области аналитики в HR.

При внедрении информационных систем в компании руководство будет интересовать также наличие модулей, позволяющих проводить аналитику BigData.

Компании начнут целенаправленно анализировать все данные, специально их готовить для удобства анализа. В результате появятся межфункциональные KPI, например HR и отдел продаж.

Также BigData покажет руководству насколько важно управление персоналом, к сожалению, у нас часто об этом забывают. По теме: Ключевые показатели эффективности отдела персонала

KPI для HR в действии

По теме: Ключевые показатели эффективности отдела персонала. KPI для HR в действии

Суть анализа больших данных

Термин «Big Data» стал широко известен не так давно – согласно «Google Trends», уровень его употребления резко возрос в 2011 году. Сегодня понятие у всех на слуху, больше всего его любят и используют в любой, даже неподходящей ситуации маркетологи.

Big Data определяют как данные:

- объем которых превышает 100Гб/500Гб/1ТБ;

- которые не могут быть обработаны в «Excel».

- не поддающиеся обработке на одном компьютере.

Суть анализа больших данных

Однако у термина есть официальное толкование, на которое и стоит опираться при работе с анализом больших данных. Это серия подходов, инструментов и методов работы со структурированной и неструктурированной информацией, которая отличается огромным объемом и значительным многообразием.

Цель такой деятельности состоит в получении результатов, которые могут восприниматься человеком и эффективны при постоянном приросте, распределении по многочисленным узлам вычислительной сети. Стоит пояснить, что речь идет об узлах, появившихся в конце 2000-х годов и выступающих в роли альтернативы традиционным системам управления базами данных и решениям класса «Business Intelligence».

Поэтому за интересующим нас термином скрываются не сведения в определенном объеме, а подходы, дающие возможность распределенно обрабатывать информацию. Они могут применяться к значительным и малым массивам данных, то есть как к содержанию всего, выложенного в Сеть, так и к одному тексту.

К системам анализа больших данных приходится прибегать при работе, например, со следующими источниками информации:

- логи поведения людей в Сети;

- GPS-сигналы транспортных средств, входящих в парк компаний, занимающихся доставкой;

- информация с датчиков Большого адронного коллайдера;

- оцифрованная литература, хранящаяся в РГБ;

- сведения о транзакциях клиентов определенного финансового учреждения;

- данные о покупках, совершенных людьми у крупного ритейлера.

Только до25 декабря

Пройди опрос иполучи обновленный курс от Geekbrains

Дарим курс по digital-профессиям

и быстрому вхождения в IT-сферу

Чтобы получить подарок, заполните информацию в открывшемся окне

Перейти

Скачать файл

В современном мире источников информации становится все больше, поэтому возрастает потребность в соответствующих технологиях обработки.

Что мешает внедрять новые технологии?

В настоящее время мы видим, что еще не все предприятия индустриальной сферы готовы тратить средства на внедрение аналитики с использованием больших данных и извлекать ее преимущества. В рамках недавнего анкетирования, проведенного американским журналом Control Engineering, более четверти опрошенных компаний заявили, что в течение ближайших нескольких лет они не планируют инвестировать в большие данные или «Интернет вещей».

В ходе проведенных исследований (рис. 2) некоторые респонденты отметили, что у них недостаточно знаний для обоснования затрат, связанных с технологией, рассматриваемой в рамках настоящей статьи. Другие ссылались на нехватку ресурсов и времени. Более половины респондентов сообщили, что у них уже есть экономически эффективные и достаточно надежные системы для обеспечения безопасности и роста доходов, а их компании успешно развиваются и без использования больших данных. В то время как сторонники рекламируют большие данные и видят их преимущество в огромном объеме информации, который может улучшить работу предприятий, скептики подчеркивают, что Big Data способствуют расширению зон для кибератак и при отсутствии достаточных защитных слоев негативно влияют на обеспечение кибербезопасности.

Рис. 2. Согласно исследованиям Control Engineering, проведенным в рамках программы оценки влияния промышленного «Интернета вещей» и интеграции информационных технологий, их имплементация может изменить рабочий процесс. Более подробная информация доступна в публикациях, посвященных проблемам Industry 4.0, мобильных вычислений, удаленного доступа к информации, робототехнике, виртуализации и беспроводным сетям, на сайте www.controleng.com/ce-research

Одно из решений проблемы, связанной с повышением отдачи от больших данных, заключается в развертывании мощных визуализаций, охватывающих все доступные данные. Это позволит обеспечить мультиструктурное и итеративное обнаружение нарушений и раскрывает информацию без необходимости направления каких-либо запросов.

Текущая осведомленность в части кибербезопасности

Непрерывный мониторинг трафика данных, собранных по всей системе предприятия в реальном времени, позволит, например, быстро обнаружить нехарактерную активность или несанкционированную деятельность и сделать это с помощью предварительного моделирования ситуации и машинного обучения в части соответствующего реагирования (рис. 1). Таким образом, владельцы предприятий и аудиторы систем защиты от киберпреступности получают беспрецедентные возможности по обнаружению и точному пониманию проблем устойчивости системы, причем независимо от того, что именно произошло: кибератака, операционный сбой или иной инцидент. В этом случае решения по захвату и анализу пакетов способны проанализировать каждый из них в реальном времени при прохождении захваченного пакета через сеть предприятия. Причем уровни протоколов для передачи пакетов можно разбить так, чтобы можно было определить маршрут, точки назначения и детали по каждому пакету данных.

Рис. 1. Непрерывный мониторинг трафика данных позволяет, например, быстро обнаружить нехарактерную активность или несанкционированную деятельность

Анализируя каждый пакет, можно разработать и использовать нормальные шаблоны трафика, позволяющие выявлять отклонения с высокой вероятностью предупреждения их возникновения. Однако существуют проблемы безопасности, исходящие непосредственно от среды получения больших данных, что также необходимо нивелировать с помощью решений, которые обеспечивают защиту и коррелируют с непрерывной эволюцией нереляционных баз данных. Здесь мы имеем в виду меры безопасности для защиты автоматизированной передачи данных, обеспечивающие высокий уровень проверки достоверности (валидации) информации для подтверждения ее аутентичности, происхождения и точности. Кроме того, необходимо противодействовать извлечению данных для последующего несанкционированного использования, предусмотреть шифрование управления доступом на основе атрибутов и наличие возможностей для подробного аудита, который может управлять таким поистине огромным объемом данных.

Функциональная архитектура

Руслан Султанов. Функциональная архитектура платформы включает две ключевые подсистемы — подсистему интеграции, выполняющую все классические задачи по сбору и загрузке данных, потоковой и пакетной обработке данных, и подсистему хранения и обработки данных, в которой выделяют различные слои хранения:

Функциональная архитектура

Платформа также включает традиционную BI-платформу, возможность создания аналитической отчетности и пользовательских отчетов, математических моделей и т. д. На базе платформы может быть организована так называемая область лаборатории данных, когда пользователям выделяются определенные ресурсы и полномочия, и они могут работать с данными внутри платформы, проверять гипотезы, в том числе, используя Python, и в целом выполнять все традиционные задачи.

Не стоит забывать про системы класса Data Governance (подсистемы управления данными), поскольку именно они обеспечивают прозрачность источников и процессов получения данных, преобразования данных перед использованием в витринах, что улучшает осведомленность пользователей и создает объективную картину данных. К решению класса Data Governance также относится каталог данных. Все эти модули в подсистеме управления данными, как правило, уместны и внедряются вместе с платформой.

К платформе можно подключать различные системы, например подсистему управления бизнес-процессами (BPM), которая обращается за данными, чтобы запустить некий бизнес-процесс.

Проблемы анализа и обработки большого объема данных

Основная проблема обработки большого массива данных лежит на поверхности — это высокие затраты. Здесь учитываются расходы на закупку, содержание и ремонт оборудования, а также заработанная плата специалистов, которые компетентны в работе с Big Data.

Следующая проблема связана с большим объемом информации, нуждающейся в обработке. Например, если в процессе исследования мы получаем не два-три результата, а многочисленное число возможных итогов, то крайне сложно выбрать именно те, которые будут иметь реальное воздействие на показатели определенного события.

Еще одна проблема — это приватность больших данных. Конфиденциальность может быть нарушена, так как все большее количество сервисов, связанное с обслуживанием клиентов, используют данные онлайн. Соответственно, это увеличивает рост киберпреступлений. Даже обычное хранение персональных данных клиентов в облаке может быть подвержено утечке. Вопрос сохранности личных данных — одна из важнейших задач, которую необходимо решать при использовании методик Big Data.

Проблемы анализа и обработки большого объема данных

Проблемы анализа и обработки большого объема данных

Угроза потери данных. Однократное резервирование не решает вопрос сохранения информации. Для хранилища необходимо создавать минимум две-три резервные копии. Но с ростом объемов данных увеличивается проблемность резервирования. Поэтому специалисты заняты поиском максимально результативного выхода из такой ситуации.

В заключение следует отметить, что развитие технологий обработки больших данных открывают широкие возможности для повышения эффективности различных сфер человеческой деятельности: медицины, транспортного обслуживания, государственного управления, финансов, производства. Именно это и определяет интенсивность развития данного направления в последние годы.

Real-time framework

Real-time framework появился в промышленных проектах, когда пришлось обрабатывать большие объемы телеметрии и других данных. Именно тогда мы пришли к выводу, что существуют стандартные сценарии обработки телеметрии, которые необходимо предусмотреть в готовом фреймворке, чтобы обеспечивать значительно более быструю и эффективную реализацию пилотных и промышленных проектов. Текущий функционал этого фреймворка может быть масштабирован на любую отрасль, в которой приходится работать с телеметрическими данными.

Real-time framework

Фреймворк обеспечивает настройку расчетов и обработку потоковых данных, которые передаются в Kafka с датчиков оборудования. Для быстрого подключения к источникам данных, в том числе промышленным, мы используем NiFi. NiFi также поддерживает промышленные протоколы для работы с телеметрией, например MQTT. Кроме того, можно использовать прекрасное расширение NiFi — MiNiFi которое позволяет собирать данные с помощью агентских технологий.

Решение является максимально масштабируемым. Мы получаем потоковые (телеметрические) данные, используем модуль расчетов и расчетные формулы, после чего расчеты сохраняются в хранилище данных, к которому уже можно подключать BI-аналитику и математические модели.

При разработке потоковых математических моделей всегда остро стоит вопрос проверки качества поступающих данных (телеметрии). Благодаря модулю потоковых расчетов можно предусмотреть все эти правила и проверить корректность поступающих данных, наличие всплесков и т. д.

Таким образом, вы получаете готовое решение «из коробки», которое позволяет сократить время для реализации как аналитических сценариев для Real-time framework, так и для построения простых дашбордов и внедрения систем предиктивной аналитики.

Инструменты пользователя

-

Система НСИ — гибкая система нормативно-справочной информации для классификации показателей с возможностью создания расчетных параметров и ведением иерархических моделей. В ней задаются расчетные и телеметрические показатели, которые должны поступать в систему.

-

Дашборды — информационные стенды с лаконично представленными статистическими данными и ключевыми метриками. Чаще всего информация представлена с элементами иконографики.

-

Ad hoc аналитика — нестандартные отчеты, которые генерируются с помощью нерегламентированных запросов (ad hoc query) к базе, хранилищу или витрине данных посредством визуального интерфейса.

-

Стандартизированная отчетность — набор документов, состав атрибутов которых зафиксирован и не подлежит изменению. Используется в качестве источника принятия управленческих и экономических решений в отношении предприятия.

-

Рабочее место Data Science специалиста — набор инструментов Data Science для проверки гипотез, построения математических моделей с использованием специализированных библиотек с доступом даже к потоковым данным. Благодаря единой точке доступа, к данным достаточно легко подключаться. Кроме того, модулем нормативно-справочной информации задается стандартизированная модель данных. Соответственно, можно подключиться из стандартного Jupiter со стандартным Python и разрабатывать и реализовывать свои математические модели.

Примеры визуализации

Платформа обеспечивает возможность анализа данных за длительный период:

-

Анализ выполнения KPI производства за отчетный период.

-

Гибкий инструментарий для выявления зависимостей (построение трендов, корреляций и т. д.)

Примеры визуализации

После того как мы собрали отклонение показателей датчиков или данные онлайн-мониторинга, можно объединить все данные в дашборд, достаточно понятный для руководителей среднего звена, для демонстрации состояния сбора данных и результатов бизнес-процессов. Кроме того, можно построить тепловую карту анализа отклонений для выявления нежелательных закономерностей, с которыми необходимо бороться. Можно также «провалиться» в детальные показания датчиков и телеметрии, чтобы посмотреть, что происходит с каким-либо показателем и почему.

При использовании типового интерфейса, пользователю предлагается просмотр древовидной структуры предприятия, включая, например, отделения и установки, по которым отображаются собираемые показатели, на вкладке Показатели. Расчетные показатели задаются на вкладке Формулы. Дополнительные атрибуты, необходимые для построения математических моделей или дашбордов по различным показателям или временным рядам, задаются на вкладке Атрибуты.

Типовой интерфейс для промышленного предприятия

Big data в банках

Помимо системы, описанной выше, в стратегии «Сбербанка» на 2014-2018 гг

говорится о важности анализа супермассивов данных для качественного обслуживания клиентов, управления рисками и оптимизации затрат. Сейчас банк использует Big data для управления рисками, борьбы с мошенничеством, сегментации и оценки кредитоспособности клиентов, управления персоналом, прогнозирования очередей в отделениях, расчёта бонусов для сотрудников и других задач

«ВТБ24» пользуется большими данными для сегментации и управления оттоком клиентов, формирования финансовой отчётности, анализа отзывов в соцсетях и на форумах. Для этого он применяет решения Teradata, SAS Visual Analytics и SAS Marketing Optimizer.

«Альфа-Банк» за большие данные взялся в 2013 году. Банк использует технологии для анализа соцсетей и поведения пользователей сайта, оценки кредитоспособности, прогнозирования оттока клиентов, персонализации контента и вторичных продаж. Для этого он работает с платформами хранения и обработки Oracle Exadata, Oracle Big data Appliance и фреймворком Hadoop.

«Тинькофф-банк» с помощью EMC Greenplum, SAS Visual Analytics и Hadoop управляет рисками, анализирует потребности потенциальных и существующих клиентов. Большие данные задействованы также в скоринге, маркетинге и продажах.

В качестве вывода

Оценивайте объемы, разнообразие, скорость прироста и

оперативность анализа своих данных. Если вы ожидаете взрывного роста или приближения

к рубежу Big Data

– для вас это серьезное основание поговорить с поставщиком вашей ECM-системы о поддержке механизмом обработки больших данных.

А также с вашим руководством о возможности повышения эффективности бизнеса за

счет раскрытия новых, неожиданных закономерностей в работе сотрудников с

корпоративной информацией.

***

Материал подготовлен на основе выступления автора на DOCFLOW 2014, а также его статьи, опубликованной на портале CNews.