Как настроить iSCSI в FreeNAS?

- Просмотрите целевые параметры глобальной конфигурации.

- Создайте хотя бы один портал.

- Определите, какие хосты могут подключаться с помощью iSCSI и создайте инициатор.

- Решите, будет ли использоваться аутентификация, и если да, будет ли это CHAP или взаимным CHAP. При использовании аутентификации создайте авторизованный доступ.

- Создайте цель (таргет).

- Создайте либо устройство, либо размер файла, который будет использоваться в качестве хранилища.

- Свяжите цель с определенной степенью.

- Запустите службу iSCSI в Services ‣ Control Services (Службах ‣ Службы контроля).

Остальная часть этого раздела описывает эти шаги более подробно.

Настраиваем доступ к nas4free через WiFi

Возможно, вам понадобится настроить доступ по второму проводному интерфейсу. Шаги будут +- те же, только проще.1) Вставляем WiFi свисток в вЫключенный комп и стартуемТем временем в командной строке[не обязательно, для развития]

Замечательно, система узнаёт наш свисток как urtwn. Другой у меня опознался так же, третий — как rsu.Насчёт 11n обольщаться не стоит.

Система автоматически подгружает нужные драйвера, if_urtwn.ko в нашем случае

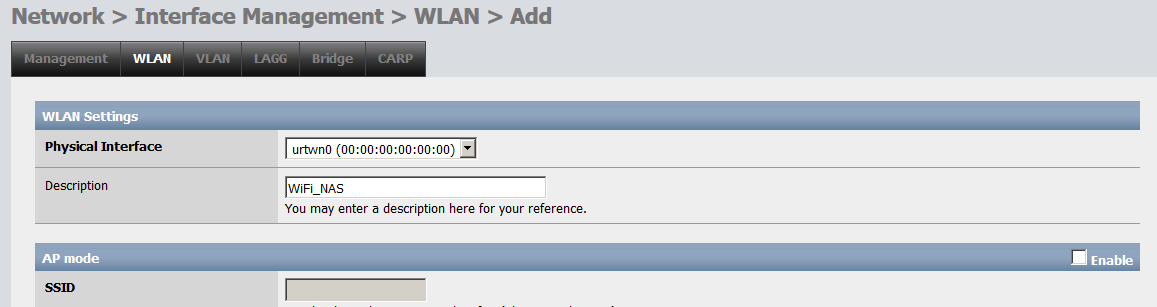

2) Идём в Network > Interface Management > WLANи добавляем новый WiFi интерфейс (серый + справа)

Нам дают выбрать наш urtwn0

Т.к. мы НЕ хотим создать точку доступа на NAS — галочку AP mode НЕ выбираем.

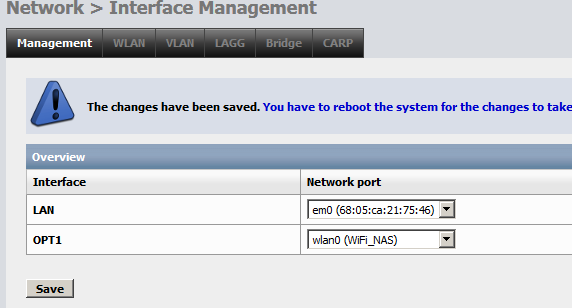

Кнопка Save и нам предлагают перегрузиться.Что и делаем.[не обязательно, для развития]Если до перезагрузки вызвать ifconfig, то нашего urtwn0 там не будет. Что противоречит куче нагугленных материалов по настройке. Оказалось, что начиная в FreeBSD 10 вторичные WiFi интерфейсы ifconfig не показывает, а показывает только wlan. Но чтобы появился wlan0 нужно добавить соответствующую строку в rc.conf. Что вебгуй и делает и затем просит перезагрузку. Ср. после неё

Но, конечно, хоть wlan0 и появился теперь в выхлопе ifconfig, статус у него no carier — не подключено.

3) После ребута NAS идём в Network > Interface ManagementСерый плюс справа позволяет добавить к стандартному LAN новый сетевой интерфейс OPT1

И снова перезагрузка

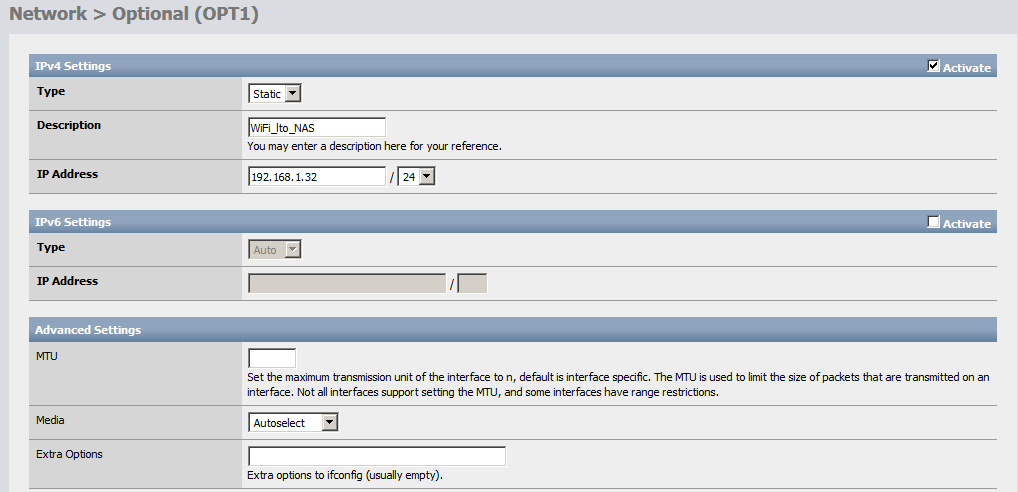

4) Теперь у нас изменилось меню Network. В нём появился пункт OPT1. Заходим туда, активируем и настраиваем Галка на активизацию IPv4, выбираем DCHP если IP будет раздавать роутер или Static, если хотим задать сами. В последнем случае не забываем выбрать подсеть (например 24).NB Капитан также напоминает, что сделать постоянный IP адрес при DCHP можно, привязав в роутере его к MAC адресу сетевой карты.

Галка на активизацию IPv4, выбираем DCHP если IP будет раздавать роутер или Static, если хотим задать сами. В последнем случае не забываем выбрать подсеть (например 24).NB Капитан также напоминает, что сделать постоянный IP адрес при DCHP можно, привязав в роутере его к MAC адресу сетевой карты.

IPv6 включаем или нет по потребности, расширенные настройки не трогаем.

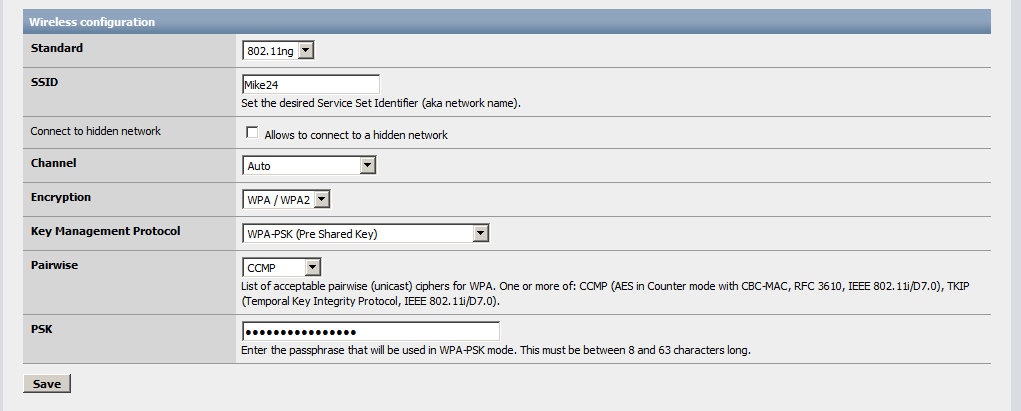

Настройки беспроводной сети обычные — для подключения к существующей WiFi сети

Сохраняем и, угадали, снова перезагрузка[не обязательно, для развития]После неё можно видеть, что вебгуй внёс изменения в rc.conf.

~# cat /etc/rc.conf | grep wlanifconfig_wlan0=»inet 192.168.1.32/24 ssid Mike24 channel any mode 11ng wepmode off WPA»wlans_urtwn0=»wlan0″

Мало того, теперь в выхлопе ifconfig должно быть видно, что подключено, к примеру:

5) По указанному IP можно, к примеру, войти по ssh с теми же параметрами, что по основному интерфейсу.

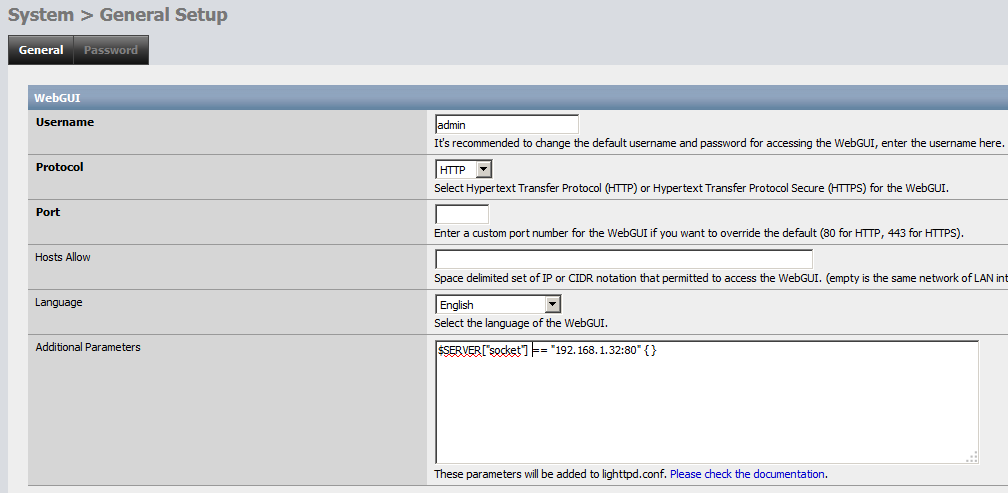

А вот в вебгуй не пустит, тут нужна отдельная настройка.Идём в System > General SetupИ в WebGUI Additional Parameters добавляем строкуЕстественно, адрес указываем тот, что выбрали ранее для второго интерфейса

И перегружаем NAS

ПРЕДУПРЕЖДЕНИЕ

Осторожно (1)Если теперь отключить второй интерфейс без удаления этой строки, то вебгуй не стартует. Придётся редактировать конфиг по живому.(2) При попытке поменять основной проводной и вторичный WiFi интерфейс, как посоветовал разработчик мне не удалось получить доступ ни по одному из них

Synology SAN Manager iSCSI LUN просто о сложном

Давайте откроем SAN Manager на Synology NAS и создадим первый LUN и iSCSI интерфейс, что бы потом подключить к ПК.

Synology SAN Manager

Первая вкладка обзорная, переходим на вкладку LUN и нажимаем создать наш первый LUN

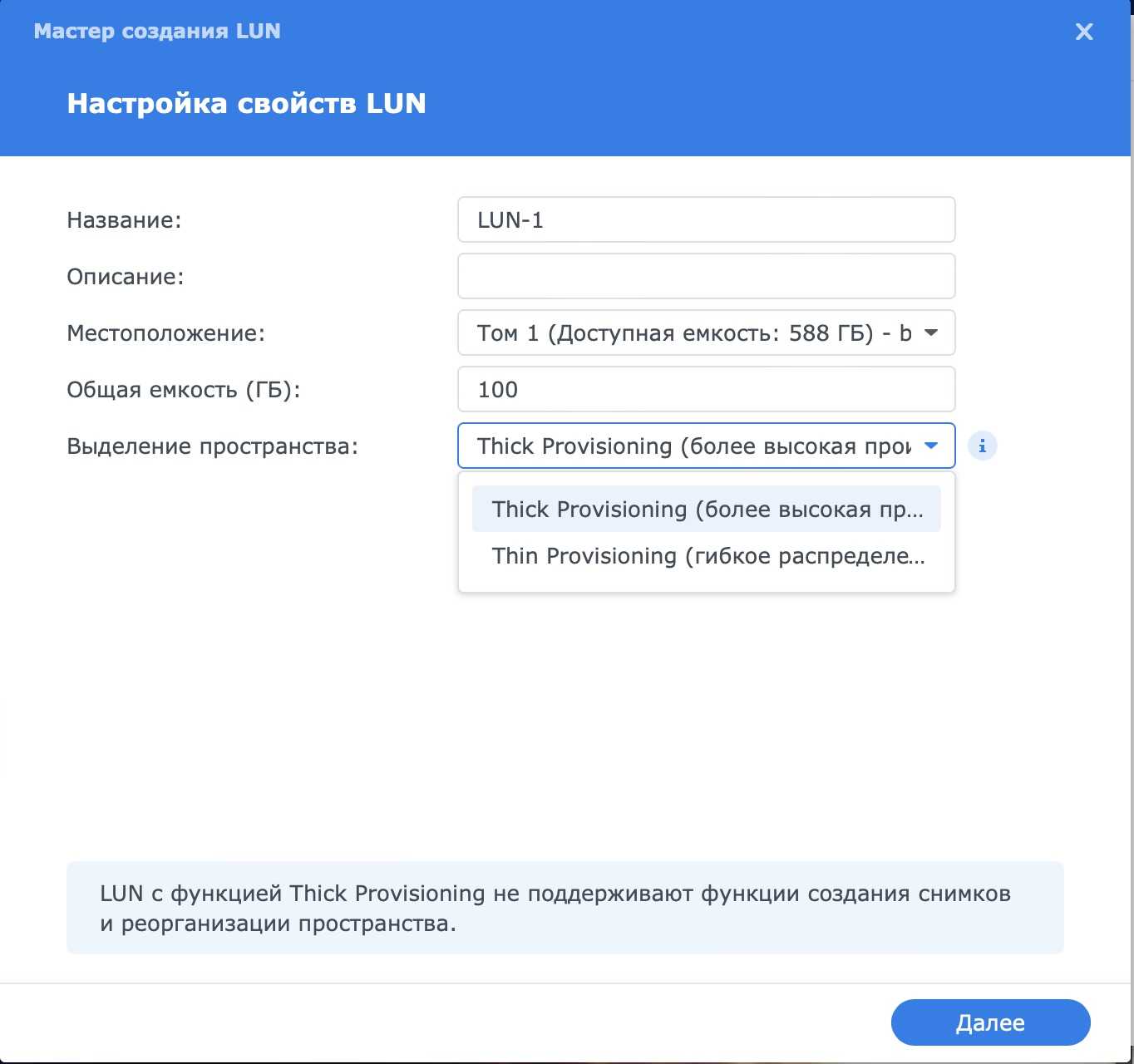

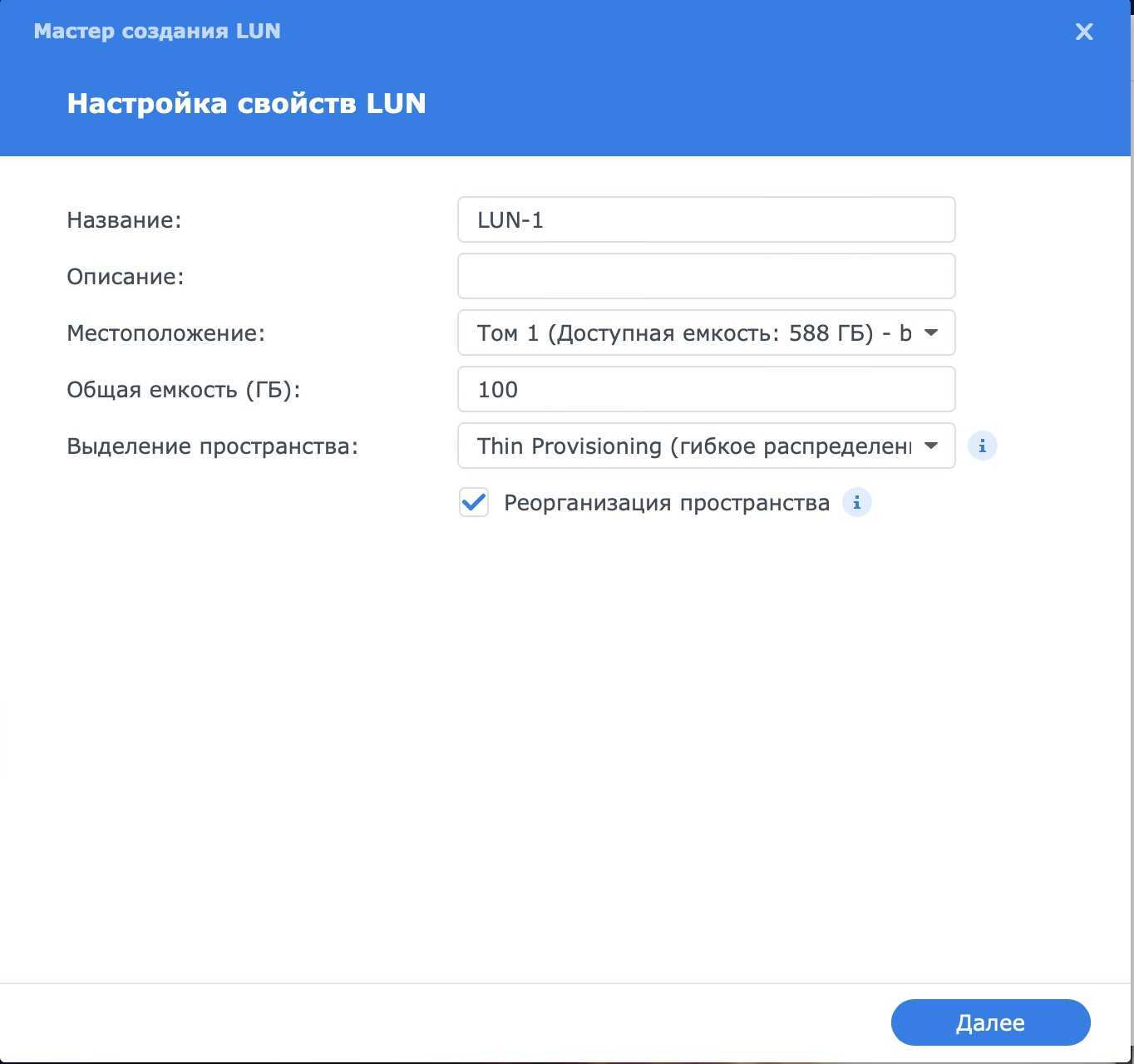

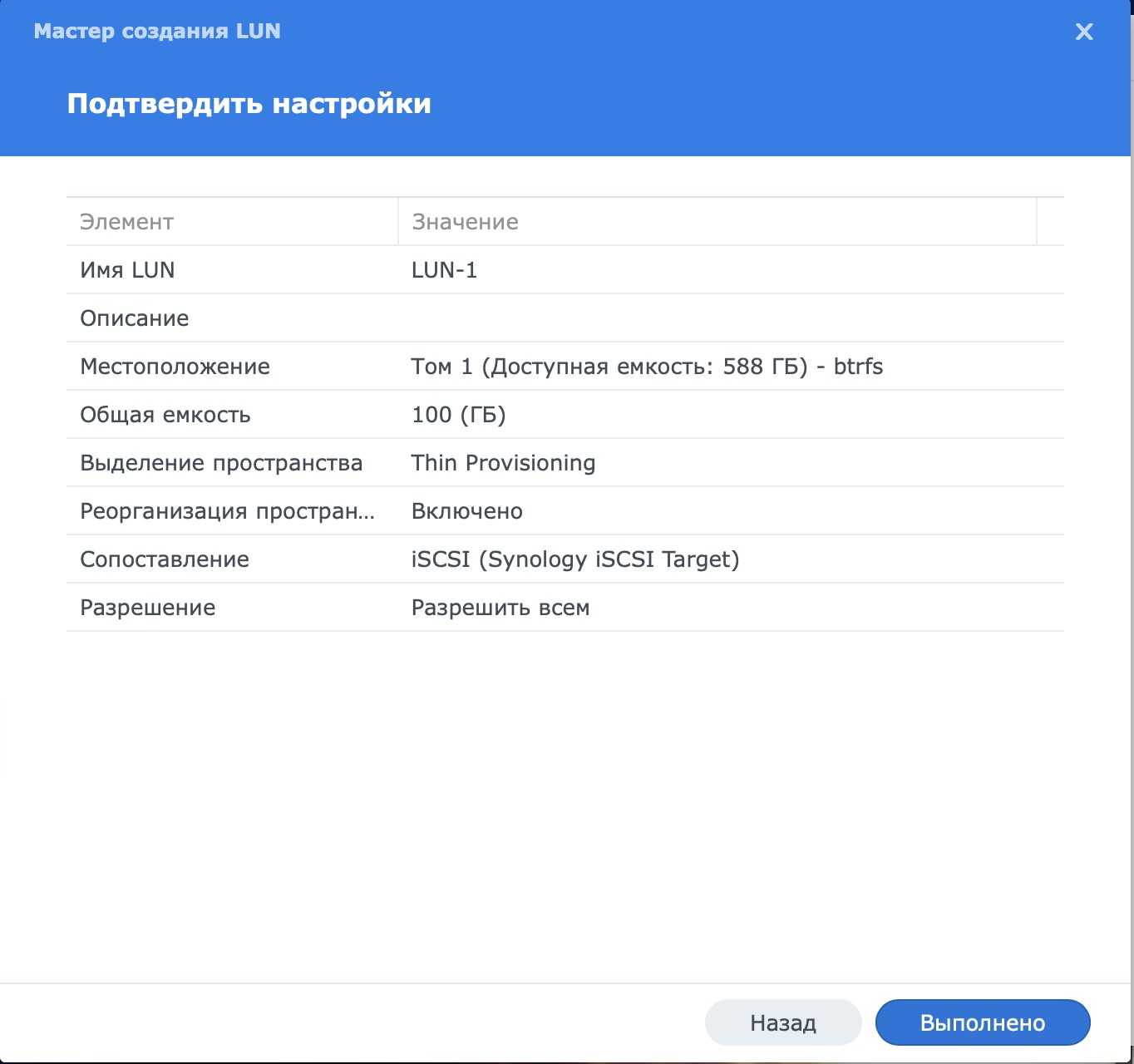

При создании LUN нам нужно выбрать название, добавить описание, место расположение и размер диска LUN. А вот выделение пространства интересная опция.

Существует два вида пространства:

Thick Provisioning — это тип выделения ресурсов хранения, при котором на момент создания LUN заранее выделяется емкость хранения на диске. Это обеспечивает меньшую задержку системы, так как хранилище уже было выделено в начале. Из минусов нельзя делать моментальные снимки. В домашних условиях особой производительности я не обнаружил.

Thin Provisioning обеспечивает выделение пространства по требованию и выступает в качестве расширенной функции LUN. LUN с Thin Provisioning обеспечивает более гибкое решение для выделения пространства. В этом режиме поддерживаются моментальные снимки и реорганизация пространства. Можно выделить 1Т, но занято на сервере будет только то, сколько реально данных будет загружено на этот LUN с ПК.

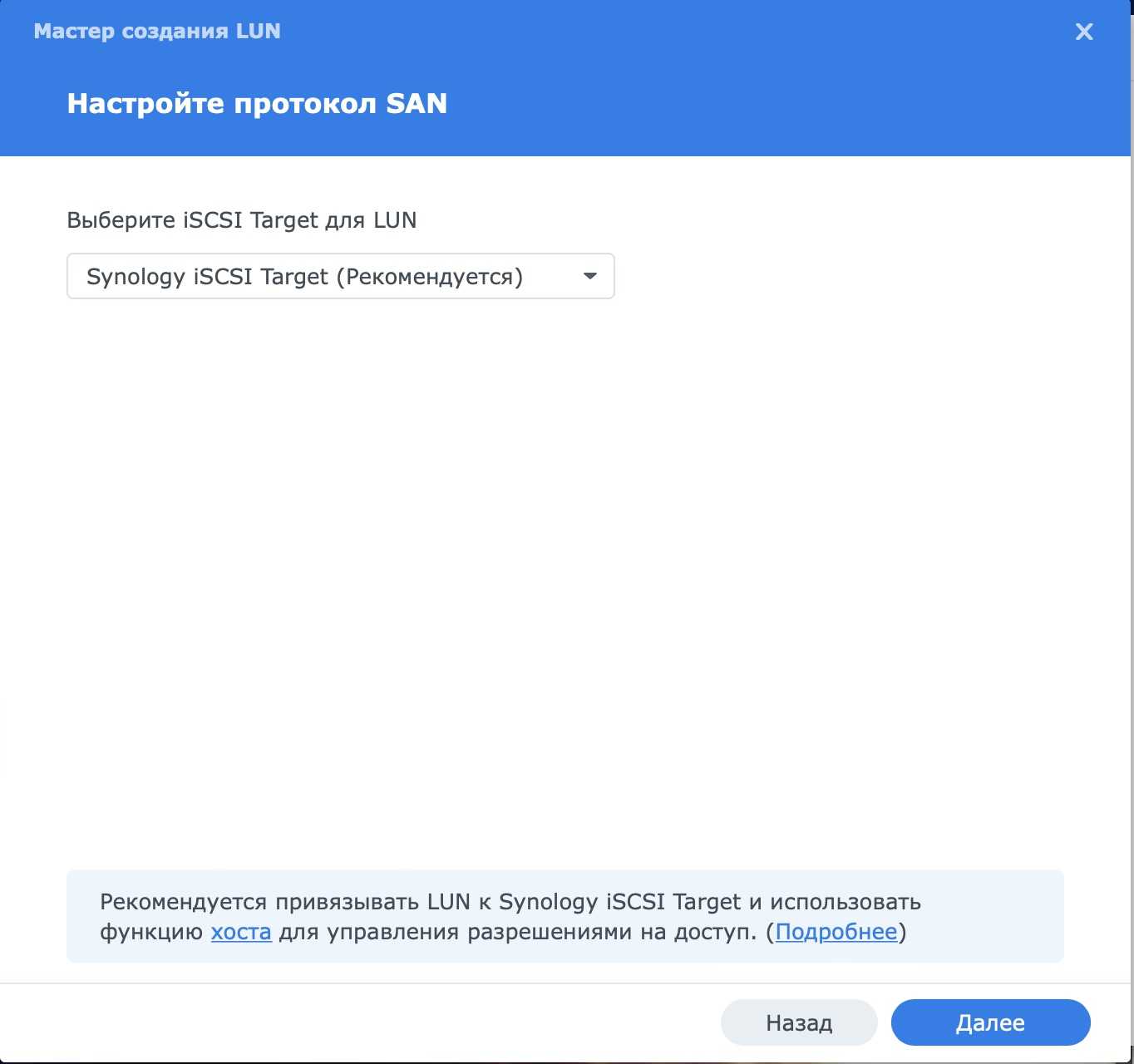

На следующем этапе система порекомендует сразу создать для этого LUN интерфейс iSCSI что я и рекомендую сделать. Тут нужно отметить, что к одному интерфейсу iSCSI можно прикрепить 1 и более дисков LUN.

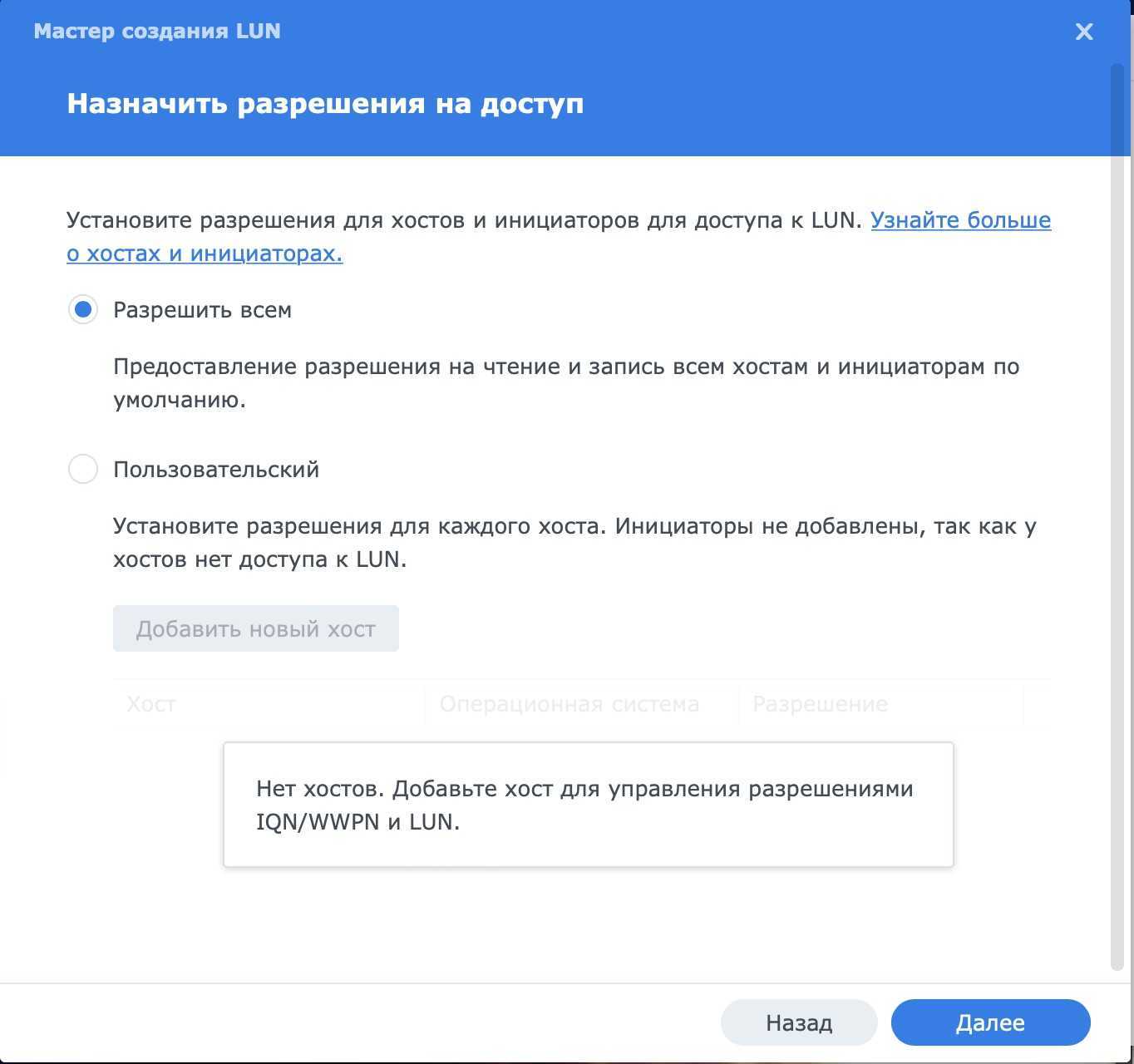

Следующим этапом нужно назначить разрешения. Так как это первый наш интерфейс, то разрешим всем, в будущем это можно изменить.

В заключении проверим, что ошибок нет и жмем выполнено

После этого в SAN Manager будет отображаться созданный нами LUN

А на вкладке iSCSI наш интерфейс

На данный момент на сервере настройки закончены и можно переходить к ПК. Я буду использовать Windows 10.

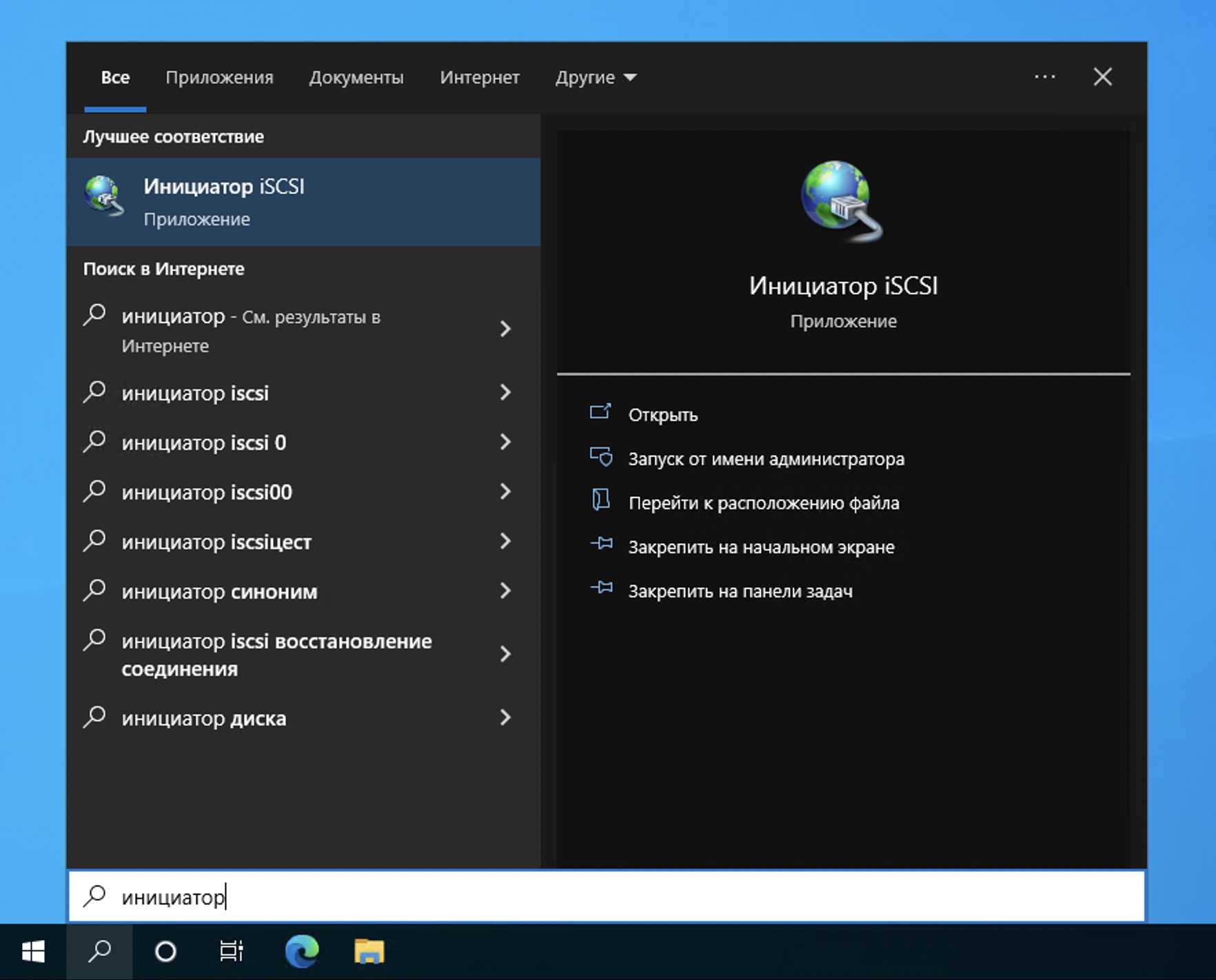

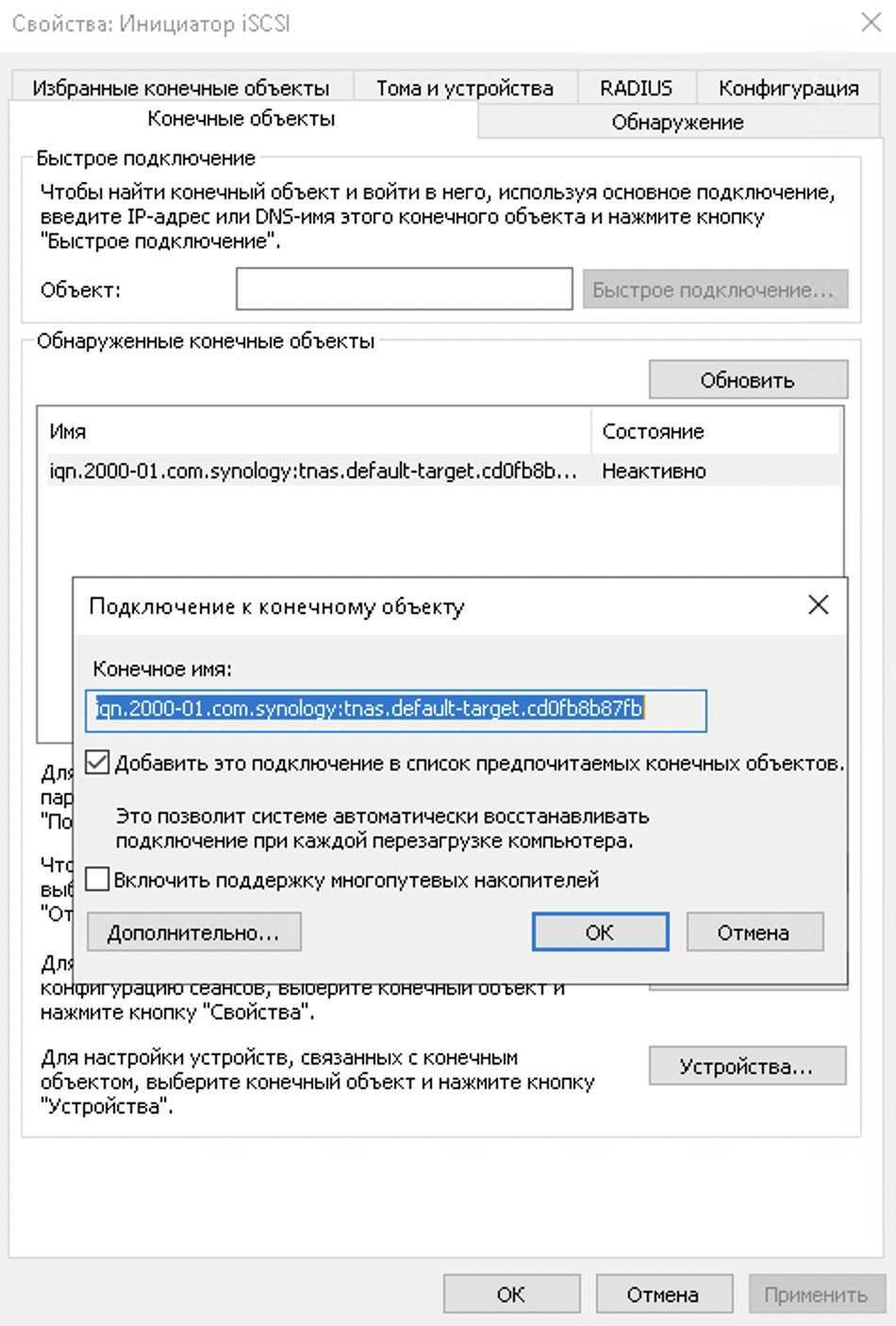

В поиске находим “Инициатор iSCSI” и запускаем его

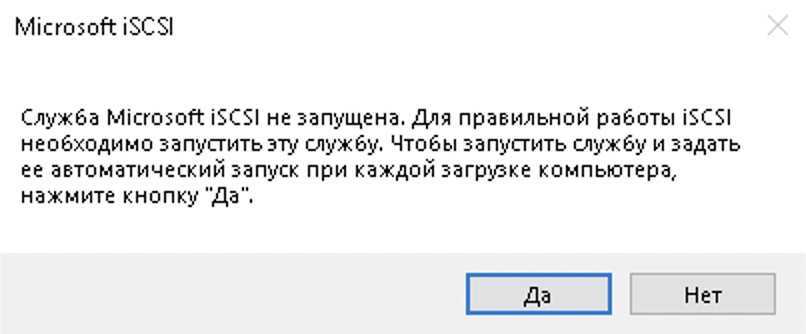

Откроется окно с вопросом о запуске службы, если вам нужно постоянно пользоваться этим, то жмите ДА

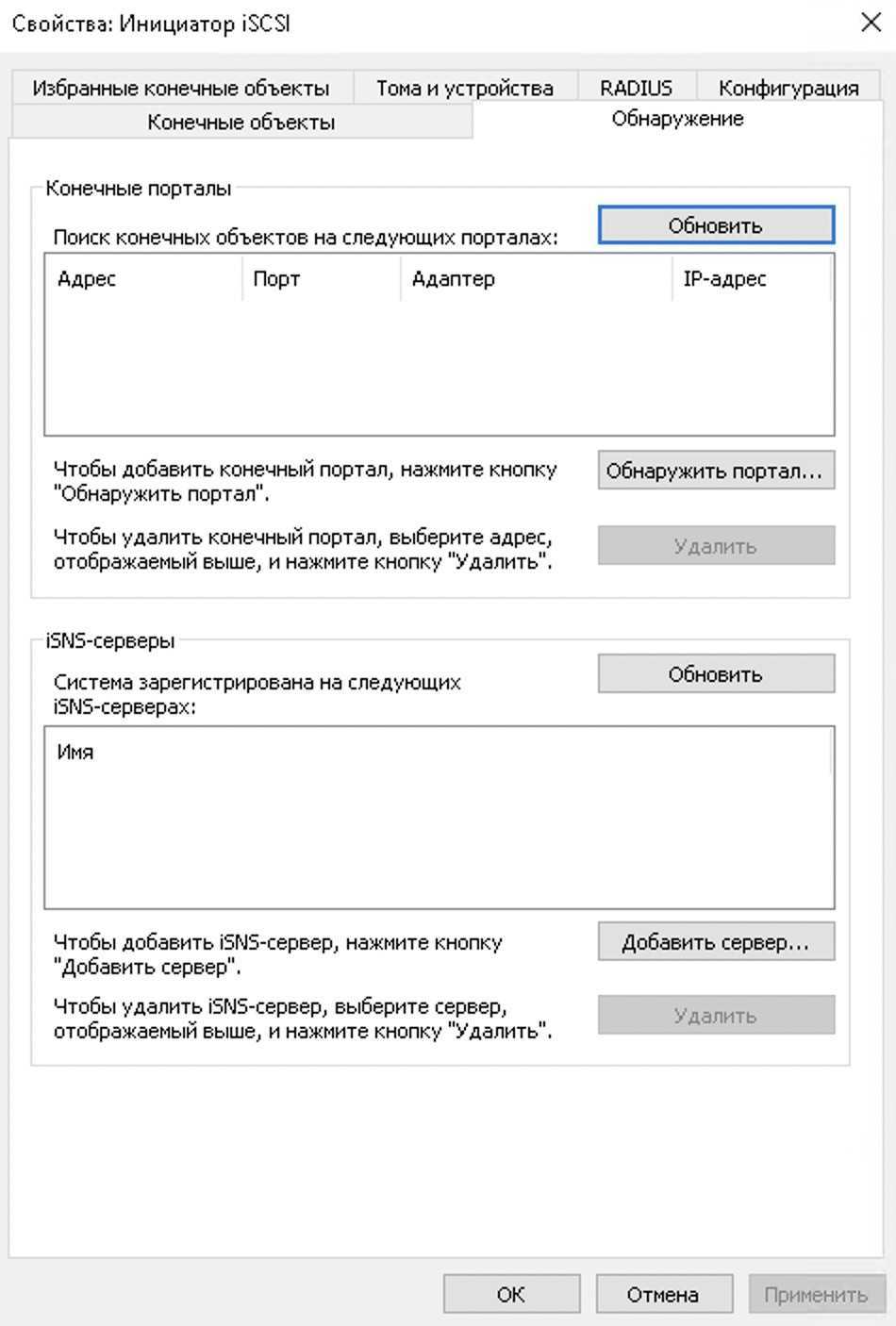

Откроется окно настроек Инициатора iSCSI

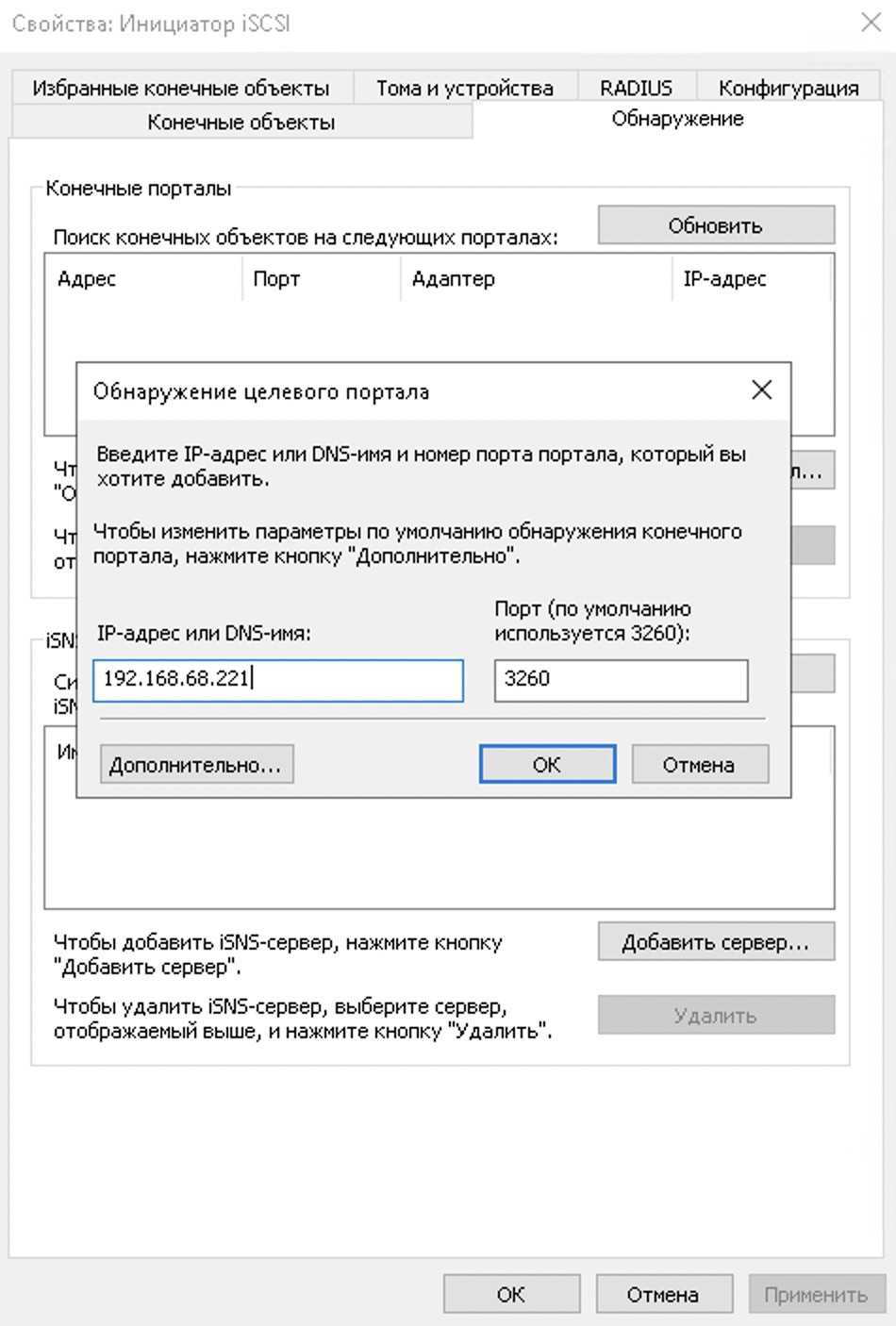

Переходим на вкладку обнаружение и нажимаем “Обнаружить портал”. Вбиваем IP адрес нашего сервера и кнопку ОК. Порт оставляем по умолчанию.

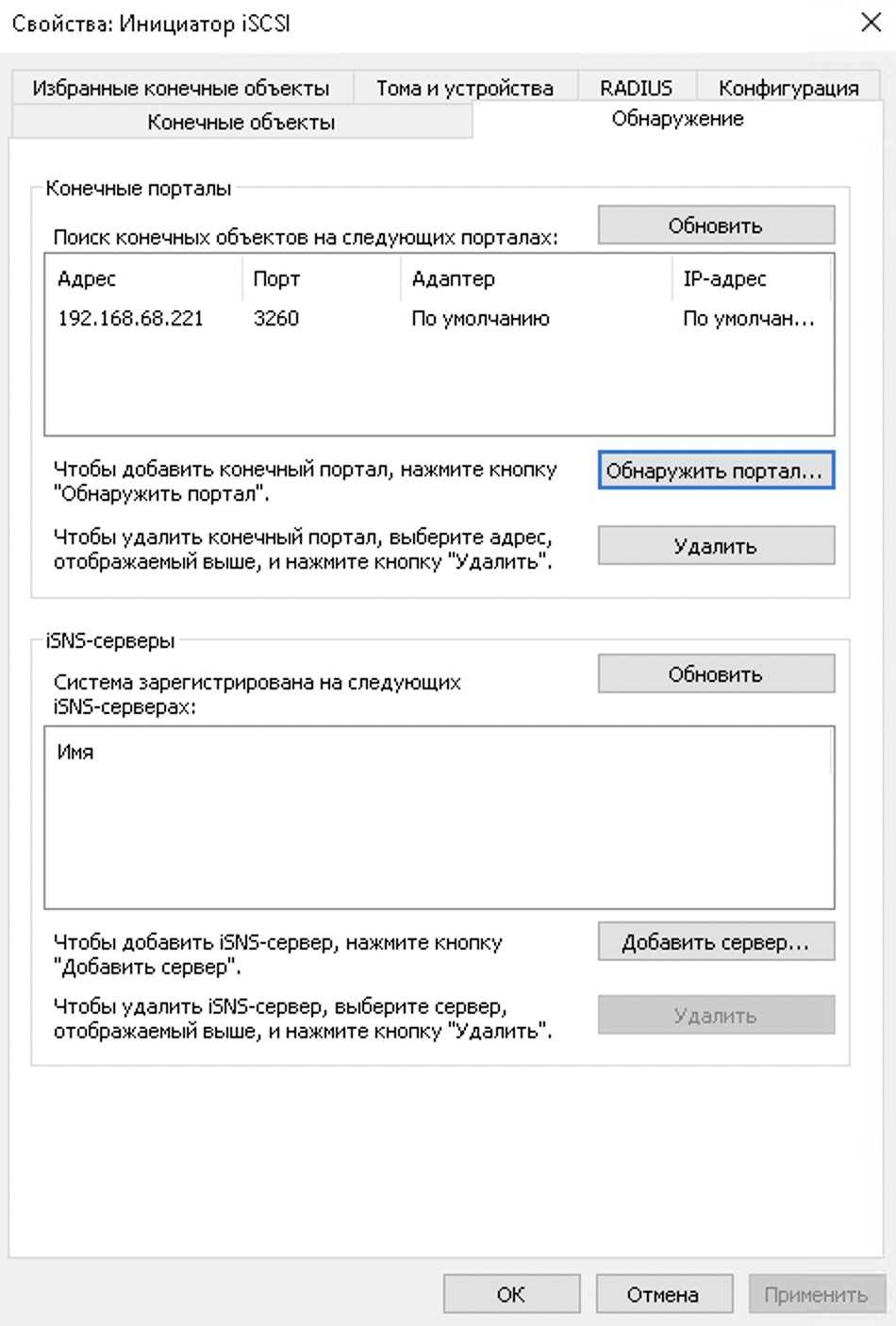

Должно получиться такое:

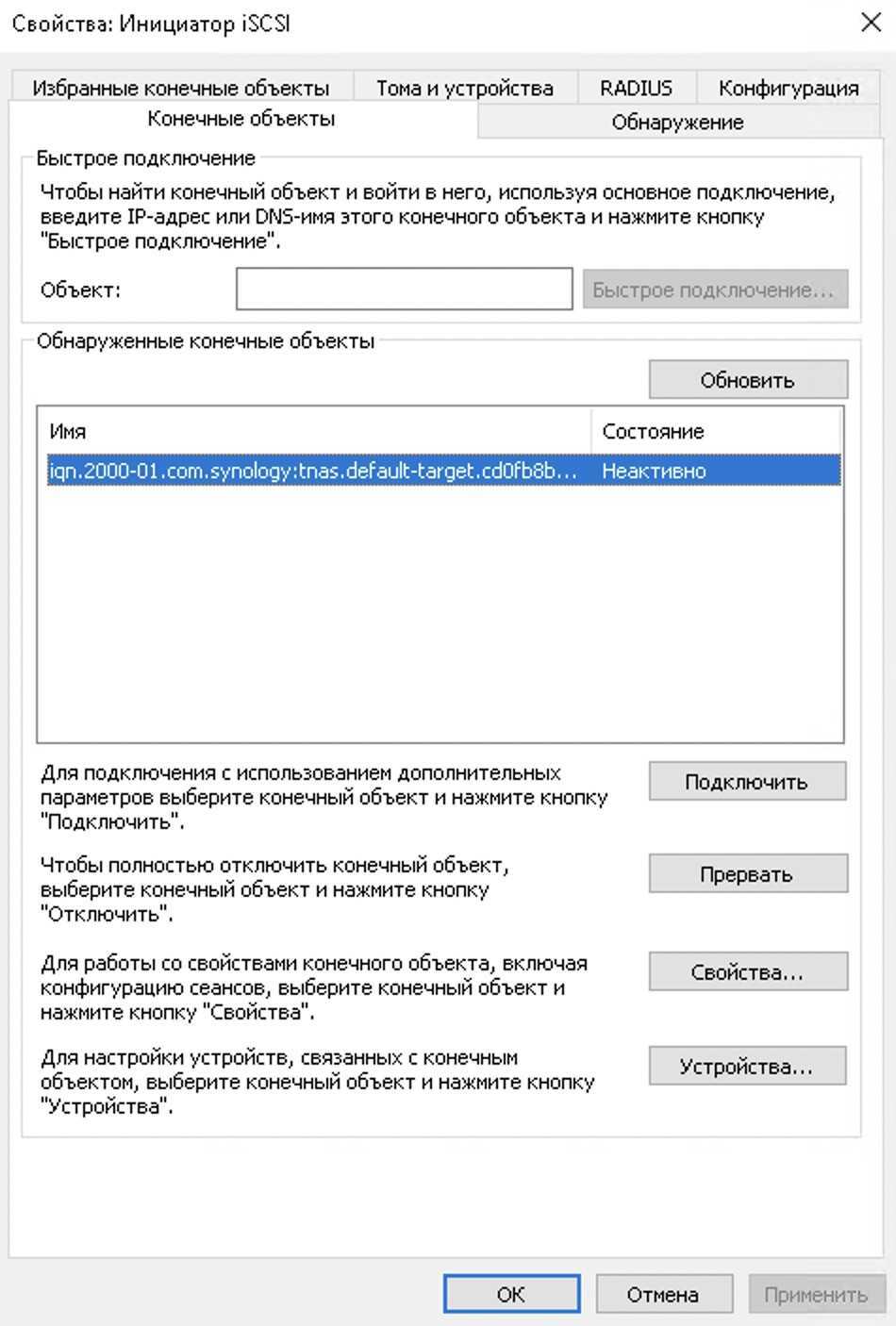

Переходим на вкладку “Конечные объекты” и видим появившийся неактивный объект

Выделяем нужный объект и жмем кнопку “Подключить”, а затем в новом окне кнопку ОК. После этого состояние изменится на “Подключено”

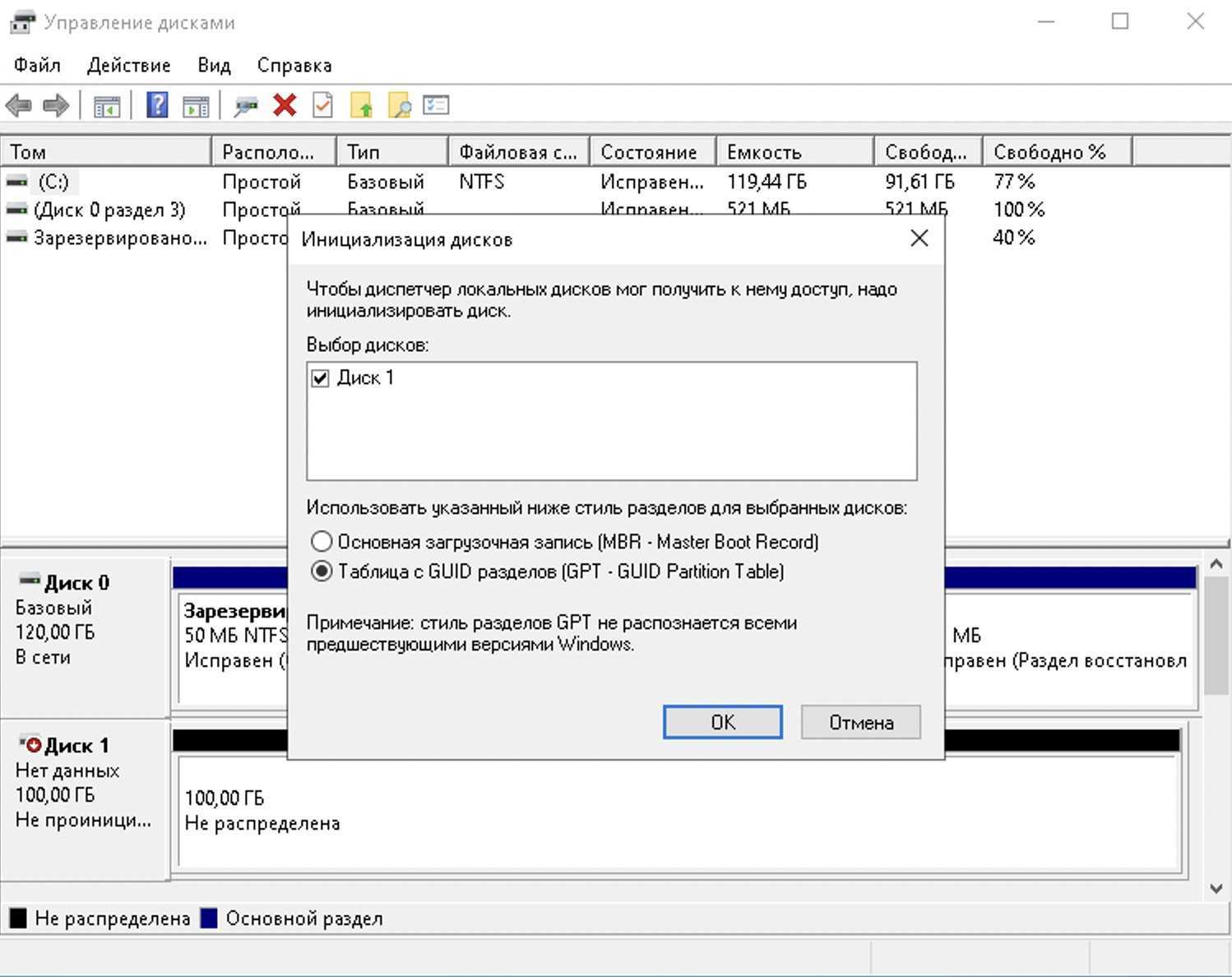

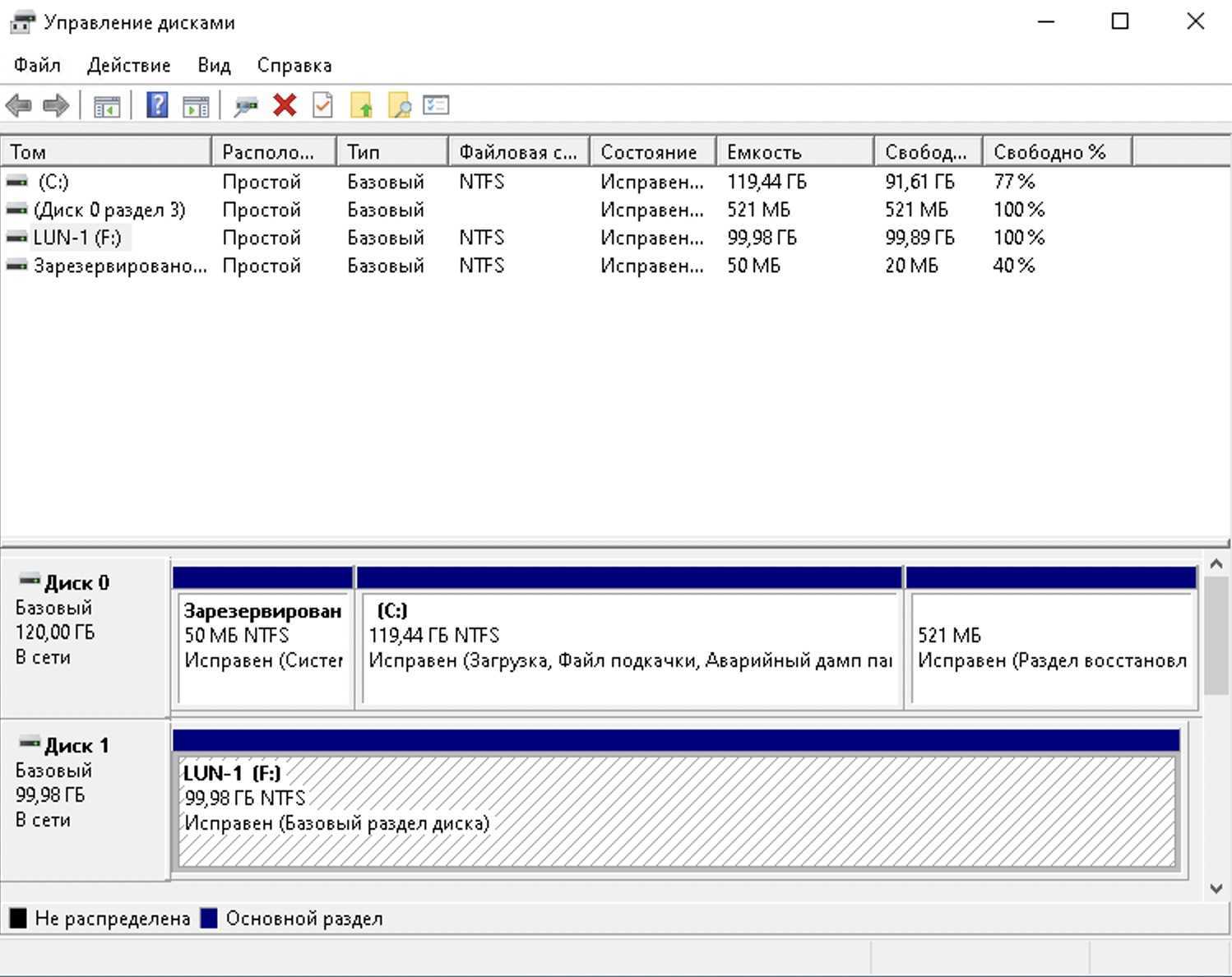

Теперь переходим в “Управление дисками” и тут нас встретит окно с предложением выбора таблицы разделов для нового обнаруженного диска. Я всегда выбираю GPT

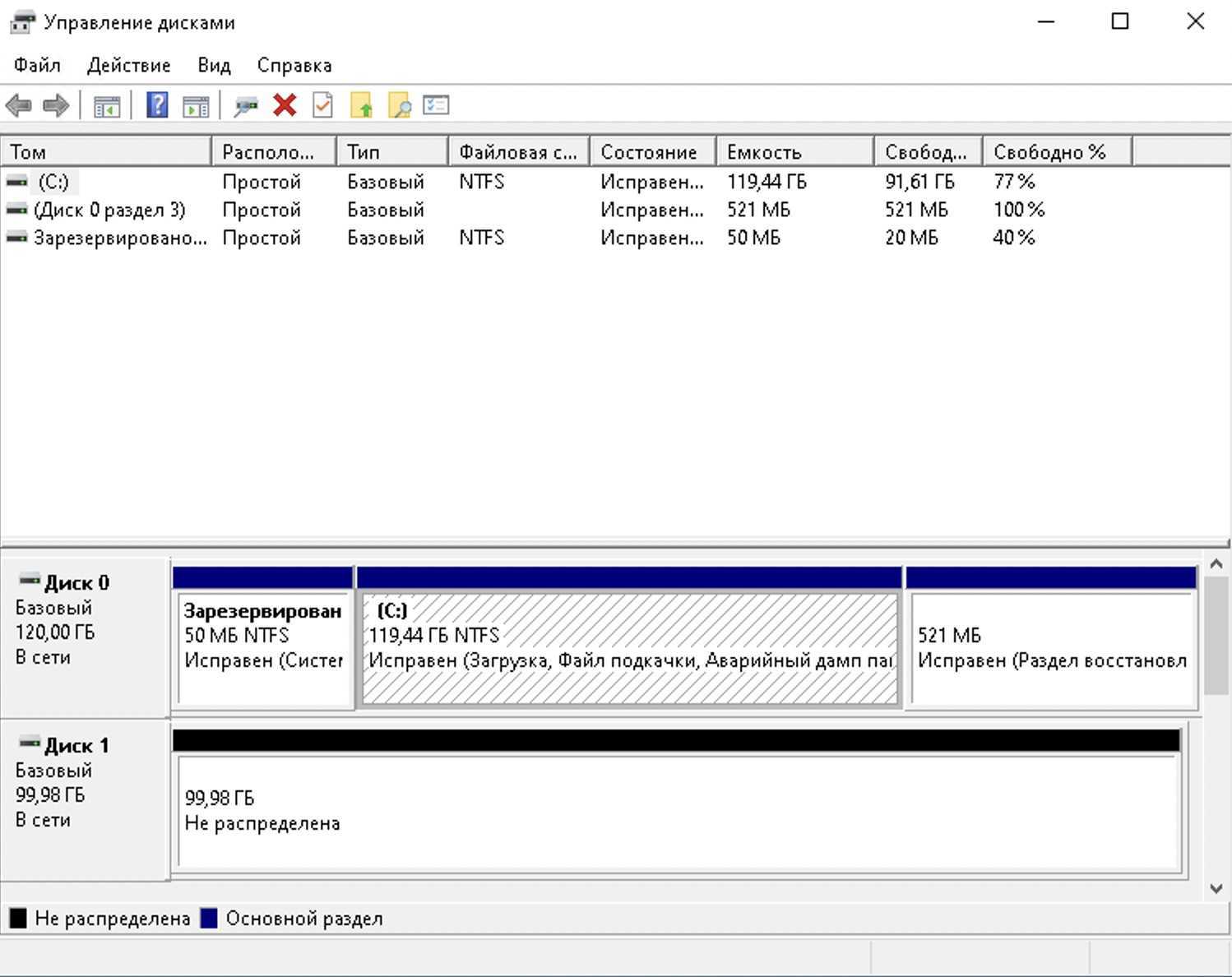

Если все сделали правильно, то увидите диск без томов.

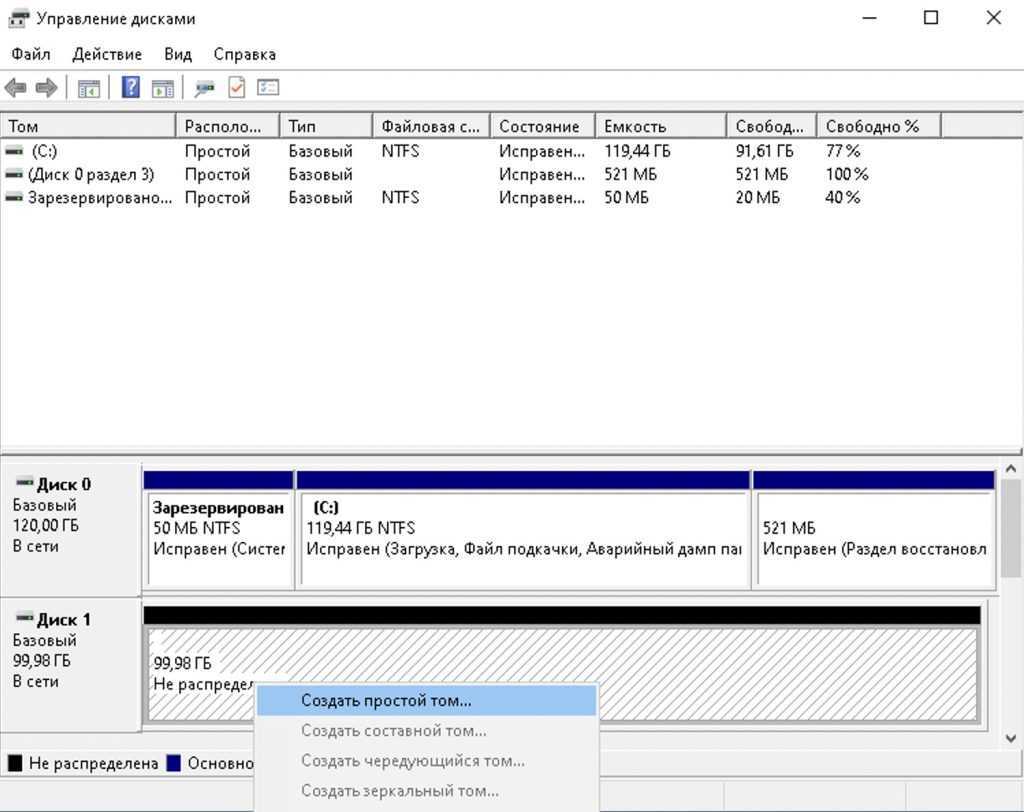

Щелкаем правой кнопкой мышки по нераспределенному месту и выбираем “Создать простой том”

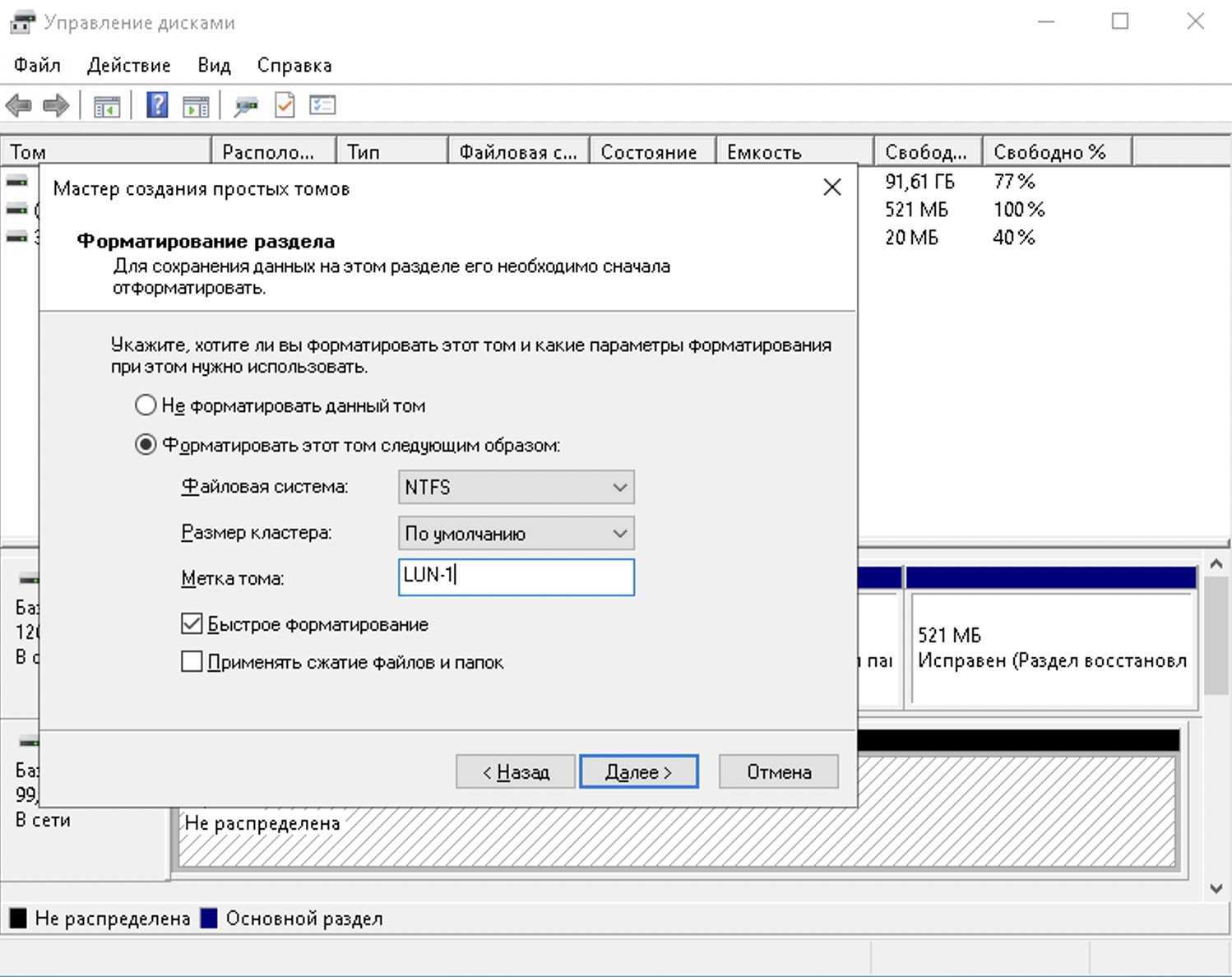

Мастер создания тома проведет нас по разным вопросам, но самый интересный это выбор форматирования диска. Тут можно выбрать любые нужные вам параметры.

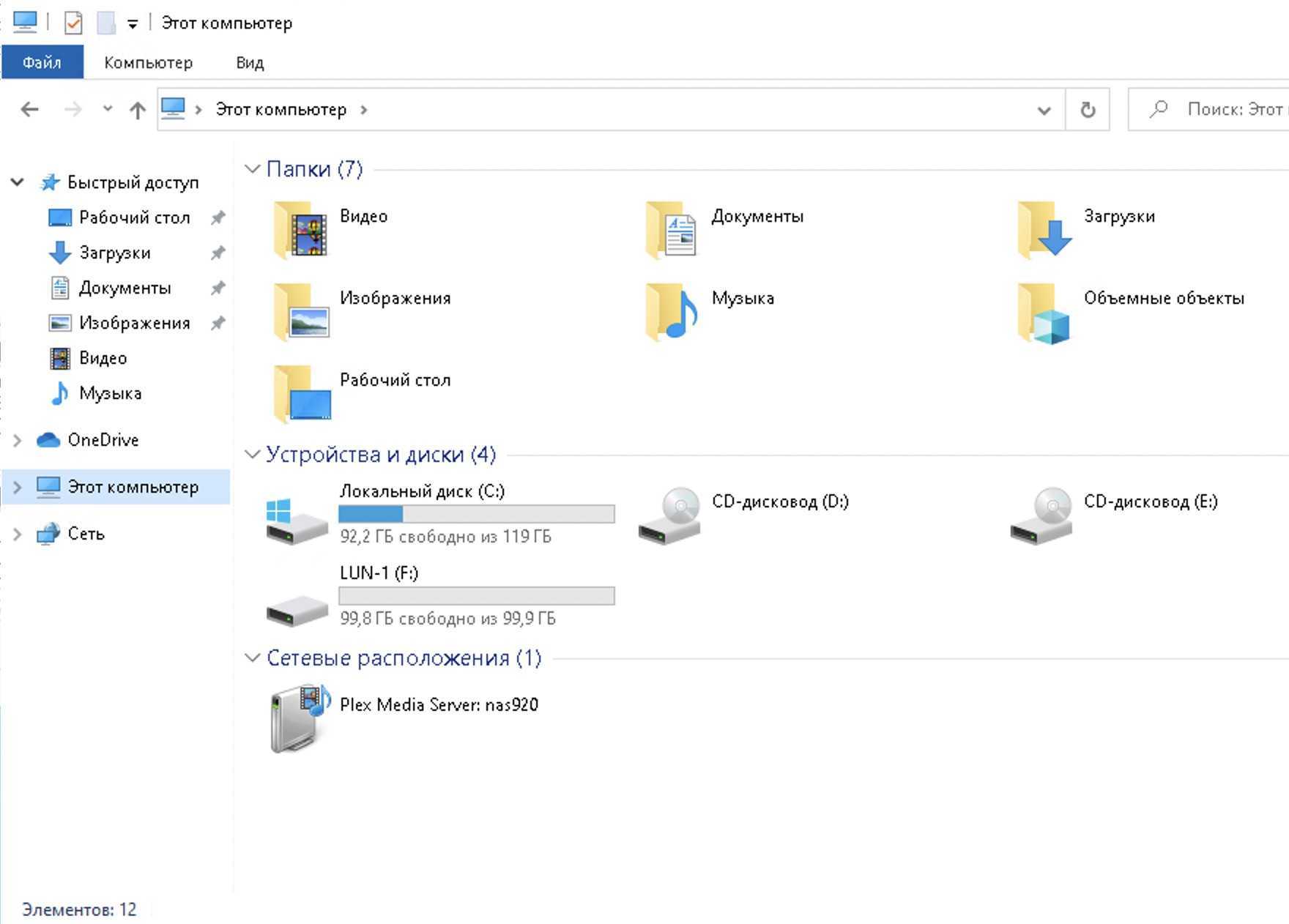

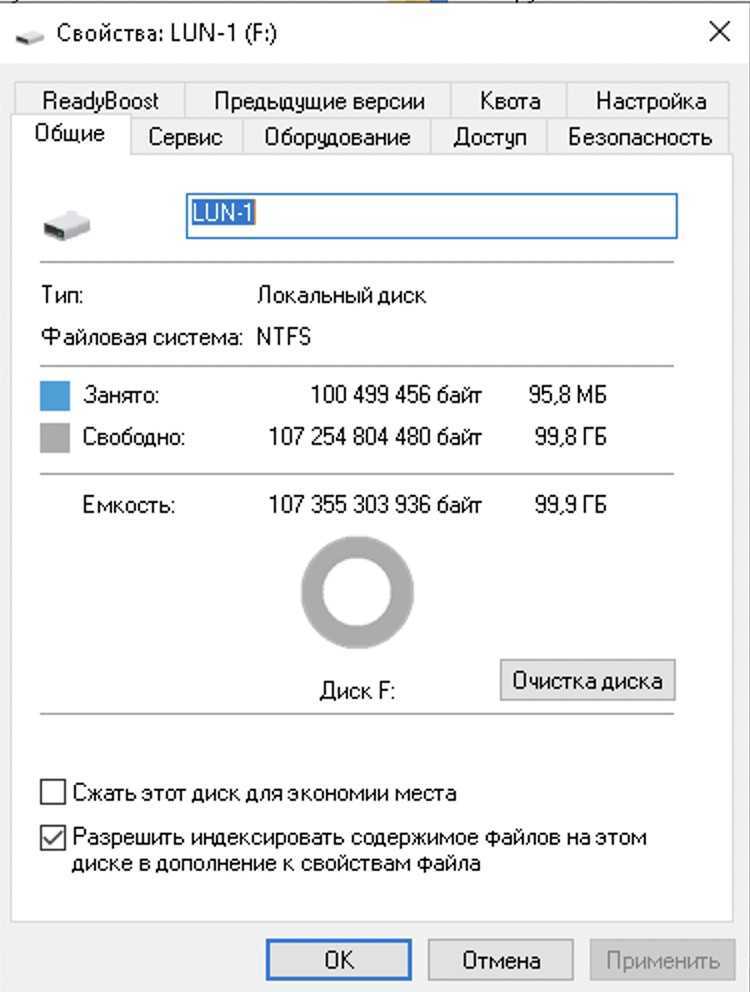

После того как диск будет отформатирован им можно начать пользоваться как обычным диском

Дальше можно перейти обратно в NAS, в раздел хосты и добавить новый хост. Это только для безопасности. Можно это не делать. Просто этим способом можно ограничить подключение хоста к LUN

Когда вы добавите хост, можно перейти в редактирование LUN и в разделе “Разрешение” указать каким хостам разрешен доступ к этому LUN.

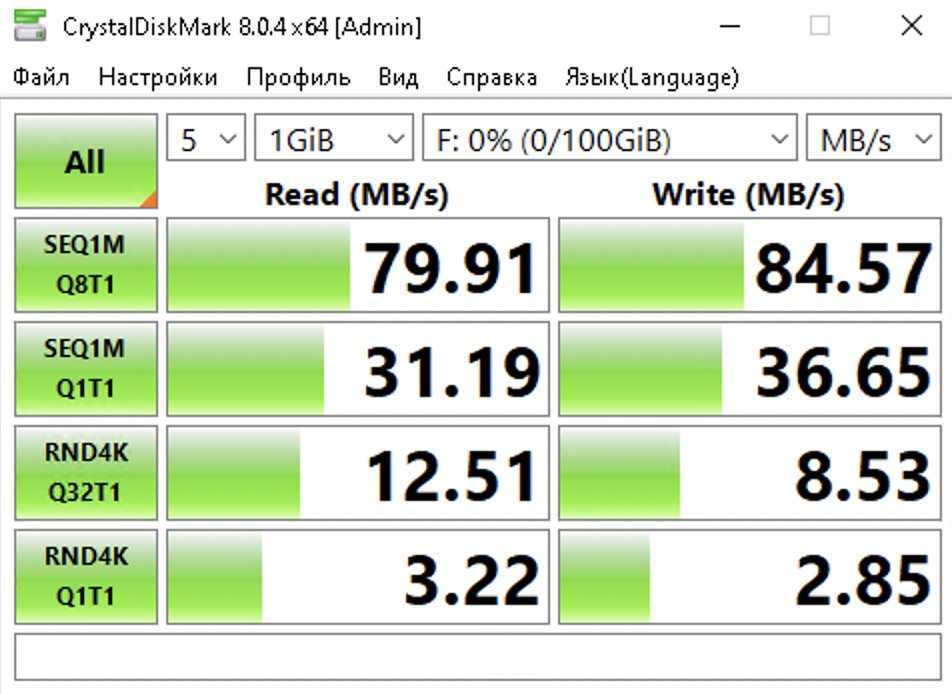

Вот такие тесты у меня получились. Если вы скажите, что это очень скромные результаты, то будите правы.

Растущие LUNы

Метод, используемый для увеличения размера существующего iSCSI LUN, зависит от того, поддерживается ли LUN размером файла или zvol. Оба метода описаны в этом разделе.

Расширение LUN одним из приведенных ниже методов дает ему больше нераспределенного пространства, но не автоматически изменяет размер файловых систем или других данных на LUN.

Это то же самое, что двоичное копирование меньшего диска на более крупный. На новом диске доступно больше места, но разделы и файловые системы должны быть расширены, чтобы использовать это новое пространство. Изменение размера образа виртуального диска обычно выполняется с помощью программного обеспечения для управления виртуальными машинами. Прикладное программное обеспечение для изменения размера файловой системы зависит от типа файловой системы и клиента, но часто запускается из виртуальной машины.

Например, рассмотрите виртуальную машину Windows с последним разделом на диске с файловой системой NTFS. LUN расширен и таблица разделов отредактирована, чтобы добавить новое пространство в последний раздел. Дисковый менеджер Windows все равно должен использоваться для изменения размера файловой системы NTFS на этом последнем разделе, чтобы использовать новое пространство.

[править] Терминология: сеансы, соединения

>

> First of all: Thanks for the possibility to ask questions

> here. I compiled and

> installed the iscsitarget 1.4.19 on CentOS 5.4 x86_32 (Linux

> gate.dentikum.ch

> 2.6.18-164.el5 #1 SMP Thu Sep 3 03:33:56 EDT 2009 i686 i686

> i386 GNU/Linux)

> and configured it with the following /etc/iet/ietd.conf:

>

> Target iqn.2010-01.ch.intersoft-networks:storage.lun1

> # IncomingUser

> # OutgoingUser

> # Lun 0 Path=/install/iscsi.img,Type=fileio

> Lun 0 Path=/install/iscsi.img,Type=fileio

> Alias LUN1

> InitialR2T Yes

> ImmediateData Yes

> # MaxOutstandingR2T 8

> MaxConnections 5

> MaxSessions 0

...

MaxSessions needs to be at least 1, the code should enforce

this, I need to make sure it does, because it sounds like it

doesn't.

IET only supports MaxConnections 1 for now.

MaxConnections is # of TCP connections per session.

> When I try to start the daemon it hangs always after some

> operations (strace

> at the end).

>

> To my other question: This is a test installation for a later

> iscsi target for

> a VMWare ESXi cluster as data storage. When I set

> MaxConnections to a other

> setting than 1 it brings always the message:

>

> iscsi_trgt: sess_param_check(46) max_connections: 5 is out of

> range (1 1)

> So my question: Is it even possible to open more than one

> connection to a

> target?

...

Currently IET doesn't support Multiple Connections per Session.

Hopefully we should get that working soon.

To help out a bit in understanding the relationships.

IET

+-> Target

| +-> Volume

| +-> Volume

| +-> Session (Initiator)

| | +-> Connection

| | +-> Connection

| +-> Session (Initiator)

| +-> Connection

| +-> Connection

+-> Target

+-> Volume

+-> Volume

+-> Session (Initiator)

| +-> Connection

| +-> Connection

+-> Session (Initiator)

+-> Connection

+-> Connection

Typically you would have multiple volumes per target if they

are to be used together, such as a cluster that has one

volume as a quorum and other data volumes, or say for VMware

were multiple volumes are concatinated to expand a VMFS

datastore. Otherwise it usually is one volume per target. The

first volume for each target MUST be LUN 0.

Конфигурация инициатора iSCSI в Debian

Следующим шагом в использовании ранее настроенной цели iSCSI является конфигурация инициатора iSCSI .

В качестве инициатора в этой статье будет использоваться другая система Debian 9, но любая система, которая может использовать протокол iSCSI, может подключиться к ранее настроенной цели; это может включать гипервизоры, такие как XenServer / ESXi или другие дистрибутивы, такие как Red Hat, Debian или Ubuntu.

Первым шагом в этом процессе для этого инициатора Debian является установка соответствующих пакетов для iSCSI .

# apt-get update # apt-get install open-iscsi

После того как apt завершит настройку пакетов open-iscsi , может начаться конфигурация инициатора iSCSI . Первым шагом будет соединение с целью получения исходной информации о конфигурации для подготовленной цели.

# iscsiadm -m discovery -t st -p 192.168.56.101

Когда эта команда будет запущена, она ответит назад с именем lun, настроенным ранее для этого конкретного хоста. Вышеприведенная команда также генерирует два файла для вновь обнаруженной информации LUN.

Подключение целевого сервера iSCSI

Теперь для файла, созданного для этого узла, должна быть настроена информация CHAP,чтобы эта цель iSCSI действительно была доступна инициатору .

Технически эта информация может быть настроена для всей системы в целом, но в том случае, если хост подключается к различным LUN с разными учетными данными, размещение этих учетных данных в файле конфигурации конкретного узла может смягчить любые проблемы.

Файл конфигурации узла будет существовать в каталоге « / etc / iscsi / nodes / » и будет иметь каталог для каждого LUN. В случае этой статьи (обратите внимание, что изменения будут изменяться, если имена / IP-адреса будут изменены)

# /etc/iscsi/nodes/iqn.2018-02.tecmint.com\:lun1/192.168.56.101\,3260\,1/default

Для работы с этим файлом можно использовать любой текстовый редактор.

# nano /etc/iscsi/nodes/iqn.2018-02.tecmint.com\:lun1/192.168.56.101\,3260\,1/default

Внутри этого файла будет несколько уже настроенных параметров для соответствующей цели,которые были определены во время команды « iscsiadm », выполняемой ранее.

Поскольку эта целевая / инициаторная установка Debian использует взаимный CHAP , некоторые другие параметры необходимо изменить и добавить в этот файл, а затем выполнить вход в цель iSCSI .

Изменения этого файла:

node.session.auth.authmethod = CHAP #Enable CHAP Authentication node.session.auth.username = tecmint-iscsi-user #Target to Initiator authentication node.session.auth.password = password #Target to Initiator authentication node.session.auth.username_in = debian-iscsi-target #Initiator to Target authentication node.session.auth.password_in = secretpass #Initiator to Target authentication

Вышеуказанные параметры позволят этой цели аутентифицироваться инициатору, а также позволяют инициатору пройти аутентификацию цели .

В этом конкретном файле есть другой вариант, который может потребоваться изменить в зависимости от настроек администратора, и это параметр « node.startup ».

Если после этого руководства параметр « node.startup » будет установлен на « ручной » в этой точке. Это может быть нежелательно. Если администратор хочет, чтобы цель iSCSI былаподключена при запуске системы, измените « вручную » на « автоматический »:

node.startup = automatic

После внесения указанных изменений сохраните файл и выйдите из него. На этом этапе сервис инициатора open-iscsi необходимо перезапустить, чтобы прочитать эти новые изменения и подключиться к цели iSCSI .

Это может быть выполнено с помощью одной из следующих команд в зависимости от используемой системы инициализации.

# service open-iscsi restart (For sysv init systems) # systemctl restart open-iscsi (For systemd init systems)

Restart Open Инициатор iSCSI

Обратите внимание, что в зеленом поле выше, инициатор iSCSI смог войти в цель . Чтобы еще раз подтвердить, что цель iSCSI действительно доступна инициатору , мы можем проверить систему на наличие дополнительных дисковых накопителей, которые доступны с помощью команды lsblk и проверки вывода для дополнительных дисков

# lsblk

Проверка целевого диска iSCSI

Другая команда, которая может быть использована инициатором для подтверждения подключения к цели, — это iscsiadm как таковой:

# iscsiadm -m session

Подтверждение соединения с целью ISCSI

Последнее место для подтверждения соединения будет на самой цели с помощью команды « tgtadm » для перечисления любых подключений iSCSI.

# tgtadm --mode conn --op show --tid 1

Конфигурация FTP-сервера

Конфигурация FTP-сервера очень проста, но мы должны перейти в раздел «Службы / FTP» и щелкнуть «Редактировать» справа. Здесь мы можем настроить порт FTP, максимальное количество клиентов, одновременные подключения, попытки входа в систему и тайм-аут, кроме того, если мы нажмем «Дополнительные параметры», будут отображены все доступные параметры.

Мы можем настроить chroot в этом «расширенном» разделе, если мы разрешим вход в систему как root, разрешения на анонимный вход для файлов и каталогов и даже активировать TLS для использования FTPES. Как будто всего этого было недостаточно, мы также можем ограничить полосу пропускания, включить нужные нам пассивные порты, протокол FXP и даже добавить дополнительные дополнительные параметры. Мы должны помнить, что TrueNAS использует Proftpd, поэтому в нашем распоряжении будут все возможности.

После того, как FTP настроен базовым способом и служба запущена, мы сможем легко получить к ней доступ, как вы можете видеть:

Если мы включим TLS, мы также сможем безопасно получить доступ благодаря протоколу FTPES. В случае конфигурации по умолчанию мы будем использовать RSA из 2048 бит и TLS 1.3, поэтому у нас будет максимальная безопасность при передаче файлов, используя AES-256-GCM, который является одним из самых симметричных алгоритмов шифрования. страховки, которые существуют сегодня.

Как вы уже видели, настроить FTP-сервер в TrueNAS CORE действительно просто и быстро.

iSCSI vs NAS

Эта часть призвана помочь системным администраторам выбрать между двумя технологиями хранения: NAS и iSCSI. и NAS, и iSCSI были разработаны, чтобы помочь удовлетворить экспоненциально растущую потребность в емкости хранения с помощью внешних масштабируемых устройств хранения, которые при необходимости могут быть объединены в сеть. Основное различие между iSCSI и NAS заключается в том, что iSCSI — это протокол передачи данных, а NAS — это распространенный способ подключения хранилища к общей пользовательской сети.

| Особенности | iSCSI | NAS over SMB |

|---|---|---|

| Уровень доступа к данным | Уровень блоков(команды SCSI, блоки данных). | Уровень объекта (файлы и папки). |

| Прямой доступ для клиентов | Необходимо настроить программное обеспечение iSCSI и сопоставить его как устройство. | Просто введите путь к общей папке, как вы это делаете для веб-сайта. |

| Доступно при использовании встроенных инструментов ОС | Обычно существует инициатор ISCSI, установленный для клиентского доступа, но вам необходимо установить цель iSCSI на сервере хранения, чтобы создать том данных. | Да, вы можете использовать практически любой файловый браузер, включая встроенный Windows/Linux/Mac. |

| Общая производительность | Зависит от инфраструктуры LAN. Можно реализовать SAN на базе 10 GbE или даже выше. | Зависит от используемой версии SMB. Для базовой версии 1 сложно полностью использовать канал 1GpE, но SMBv3 позволяет использовать многоканальный режим, который может многократно увеличить общую производительность. |

| Может использоваться как бэкэнд серверных приложений | Да, благодаря доступу на уровне блоков с использованием общих команд SCSI. | Только для определенных серверных приложений (например, VMware vCenter HA), использующих SMB v2/3. |

| Сложность реализации | Реализация на уровне производства требует установки специальной сетевой карты, настройки сетевых устройств и установки специального серверного программного обеспечения. | Достаточно тщательной настройки встроенных функций сервера для легкого доступа клиентов. |

| Готовы к работе с кластерами HA | Да, поддерживается практически любой технологией кластеризации, так как она основана на протоколе SCSI. | Только для определенных технологий кластеров серверов, которые поддерживают хранилище SMB/NFS в качестве общего тома. |

Что такое SAS (Serial Attached SCSI), FC (Fibre Channel) и iSCSI (Internet Small Computer System Interface)?

Традиционно устройства SCSI, такие как внутренний жесткий диск, подключаются к общей параллельной шине SCSI. Это означает, что все подключенные устройства будут использовать одну и ту же шину для отправки / получения данных. Но совместные параллельные соединения не очень хороши для высокой точности и создают проблемы при высокоскоростных передачах. Однако последовательное соединение между устройством и сервером может увеличить общую пропускную способность передачи данных. SAS между устройствами хранения и серверами использует выделенный 300 МБ / сек на диск. Подумайте о шине SCSI, которая имеет одинаковую скорость для всех подключенных устройств.

SAS использует одни и те же команды SCSI для отправки и приема данных с устройства. Также, пожалуйста, не думайте, что SCSI используется только для внутреннего хранилища. Он также используется для подключения внешнего устройства хранения к серверу.

Если производительность передачи данных и надежность являются выбором, то использование SAS — лучшее решение. С точки зрения надежности и частоты ошибок диски SAS намного лучше по сравнению со старыми дисками SATA. SAS был разработан с учетом производительности, благодаря которой он является полнодуплексным. Это означает, что данные могут быть отправлены и приняты одновременно с устройства, использующего SAS. Также один хост-порт SAS может подключаться к нескольким дискам SAS с использованием расширителей. SAS использует передачу данных точка-точка, используя последовательную связь между устройствами (устройствами хранения, такими как дисковые накопители и дисковые массивы) и хостами.

Первое поколение SAS обеспечило скорость 3Gb / s. Второе поколение SAS улучшило это до 6 Гбит / с. И третье поколение (которое в настоящее время используется многими организациями для экстремально высокой пропускной способности) улучшило это до 12 Гбит / с.

iSCSI vs Fibre Channel

Fibre Channel (FC) and iSCSI are two key SAN-related technologies and these two technologies solve the same technical problem of networking block storage while have been positioned as fierce competitors. People often ask Fibre Channel SAN vs iSCSI SAN: Which is better for SAN? This comparison of Fibre Channel vs iSCSI will help you make your decision:

| Feature | FC | iSCSI |

|---|---|---|

| Allows for use on existing network | NO | YES |

| Block-level access | YES | YES |

| Strong data flow management (CRC check, avoids transmission retries) | YES | NO |

| Embedded service infrastructure | YES | NO |

| Network isolation by design | YES | NO |

| Need to buy special hardware (adapters, switches, etc.) | YES | YES/NO (good performance impossible without special adapters) |

| Transfer speeds available | 2/4/8/16/32 Gbps, support for link aggregation | 1/10/40/100Gbps, support for link aggregation |

Рекомендации и тюнинг

DRBD

Как я отметил выше, всегда желательно использовать отдельную сеть под репликацию. Крайне желательно использовать 10-гигабитные сетевые адаптеры, в противном случае у вас все упрется в скорость портов.

Если репликация вам кажется достаточно медленной попробуйте потюнить некоторые параметры для DRBD. Вот конфиг, который на мой взгляж является оптимальными для моей 10G-сети:

Подробнее про каждый параметр вы можете получить информацию из официальной документации DRBD

Open-iSCSI

Так как мы не используем multipathing, в нашем случае рекомендуется отключить переодические проверки соединения на клиентах, а так же увеличить таймауты ожидания для восстановления сессии в .

Процесс настройки iSCSI через FreeNAS

Прочитано:

1 183

iSCSI. Это протокол, основанный на TCP/IP

- Инициатор (initiator) — iSCSI-клиент, которому будет доступно хранилище;

- Таргет (target) — iSCSI-сервер, который предоставляет доступ клиентам к своим устройствам по протоколу iSCSI.

И так у нас установлен FreeNAS под Virtualbox на Windows 7.

Открываем браузер «Mozilla Firefox» (в IE постоянно слетал статус запущенности службы), далее заходим по Web интерфейсу на сервер управления FreeNAS, в моём случае – это

http://10.0.2.30 выданный по DHCP от dc1.polygon.local

Сначала включим службу iSCSI

Services» Control Servises»iSCSI

Нажимаем на гаечный ключ и попадаем в окно настроек:

после на «Authorized Access» – «Add iSCSI Authorized Access» (для создания пользователя)

Указываем

Group ID = 1

User = user_iscsi

Secret = Aa1234567

User = user_iscsi

Secret = Bb1234567

Пароль должен быть не менее 12 символов, в противном случае при соединении инициатора с таргетом вы получите сообщение, что Секрет «CHAP» конечного объекта меньше минимального размера (12 байт), который требуется по спецификации:

И далее идём в секцию «Initiators» – «Add Initiator», вводим нашего пользователя user_iscsi, а в поле Authorized network можно оставить ALL, но лучше в целях безопасности задать маску локальной подсети (10.0.2.0/24), я же поставлю везде ALL.

переходим в секцию «Portals»:

«3260» — это порт, используемый протоколом iSCSI по умолчанию

Переходим в секцию «Target Global Configuration». Указываем в поле Base Name имя сервера iSCSI. В локальной сети имя сервера FreeNAS — freenas.local. Префикс iqn.2011-03 используется для уникальности имён. Таким образом, установим Base Name в iqn.2011-03.freenas.polygon.local, остальные параметры оставляем без изменений:

iqn.2011-03.freenas.polygon.local

Discovery Auth Method – Auto

Discover Auth Group – 1 (я её назвал выше так, при создании пользователя)

Сохраняем параметры – Save

Переходим в секцию Targets и нажимаем кнопку Add Target, и устанавливаем параметры в соответствии с указанными на скриншоте настройками и нажимаем OK:

Дальше нужно задать Extents (экстенты).

Экстенты могут быть двух типов файловый (Extent) и устройство (Device Extent). Если выбрать файловый, то вы можете использовать хранилище в виде файла на существующем диске (но не на системном, файловый экстент может быть создан только на точках монтирования), если тип-устройство, то можно подключить диск или CD/DVD привод.

Я рассмотрю вариант использование хранилища в виде подключённого диска.

Переходим в «Device Extentes», где Disk Device – это диск созданный средствами Virtualbox и подключённый к FreeNAS серверу.

Далее переходим в секцию «Associated Targets» и нажимаем кнопку «Add Extent to Target»:

Вот собственно и всё, я показал на действующем примере как создать подключение диска в виде iscsi к серверу FreeNAS запущенному под виртуальной системой Virtualbox. Данный материал пригодится в дальнейшем описании заметок на моём блоге.

How to Build an iSCSI SAN?

iSCSI SAN is suitable for small/medium-sized businesses that have large amounts of data to store and transmit over the network. Here gives some tips on how to set up and configure iSCSI SAN for enterprise network:

First, though iSCSI storage network can run on existing network infrastructure, it is better to place iSCSI traffic on its own VLAN, preferably on a completely separate, gigabit-speed network. This helps to make a redundancy connection for storage data in case of network failure.

Second, you’d better use an enterprise-class, non-blocking, Gigabit Ethernet switch for iSCSI SAN. A consumer-grade switch often does not support wire-speed connections between multiple ports, therefore they may drop packets without warning. For data center applications, 10GbE iSCSI SAN is more future-proofing, so 10GbE switch is preferred.

Lastly, if your servers have single-Gigabit connections to an Ethernet switch for access to disk arrays, they are vulnerable to failure on that link. The best way is to use Multipath I/O (MPIO) technique to create multiple connections from each server’s iSCSI initiator to your disk array.

Что следует учитывать при выборе NAS?

Выше мы рассмотрели несколько популярных функций, которые должно поддерживать современное сетевое хранилище. Мы рекомендуем отметить те функции, которые могут понадобиться. И уже при выборе хранилища проверять, какие из функций оно поддерживает. Учтите, что список функций практически безграничный, как и число пакетов, которые можно установить на NAS. Поэтому здесь мы не претендуем на полный охват.

После того, как определились с функциями, настало время перейти к характеристикам сетевых хранилищ. Их следует учитывать при выборе подходящей модели. И ниже мы рассмотрим наиболее важные характеристики.

DAS

Direct Attached Storage — это исторически первый вариант подключения носителей, применяемый до сих пор. Накопитель, с точки зрения компьютера, в котором он установлен, используется монопольно, обращение с накопителем происходит поблочно, обеспечивая максимальную скорость обмена данными с накопителем с минимальными задержками. Также это наиболее дешевый вариант организации системы хранения данных, однако не лишенный своих недостатков. К примеру если нужно организовать хранение данных предприятия на нескольких серверах, то такой способ организации не позволяет совместное использование дисков разных серверов между собой, так что система хранения данных будет не оптимальной: некоторые сервера будут испытывать недостаток дискового пространства, другие же — не будут полностью его утилизировать:

Конфигурации систем с единственным накопителем применяются чаще всего для нетребовательных нагрузок, обычно для домашнего применения. Для профессиональных целей, а также промышленного применения чаще всего используется несколько накопителей, объединенных в RAID-массив программно, либо с помощью аппаратной карты RAID для достижения отказоустойчивости и\или более высокой скорости работы, чем единичный накопитель. Также есть возможность организации кэширования наиболее часто используемых данных на более быстром, но менее емком твердотельном накопителе для достижения и большой емкости и большой скорости работы дисковой подсистемы компьютера.

![Настройка хранилища iscsi | vmware esxi vmotion [v-grade]](http://robotrackkursk.ru/wp-content/uploads/6/f/e/6fe94c1e46bb0ea8ea2daf86a29975bb.png)