Развертывание Oracle RAC

Рассмотрим этапы установки различных компонентов, необходимых для функционирования Oracle RAC в режиме active/active кластера с двумя узлами. В качестве дистрибутива будем рассматривать последнюю на момент написания статьи версию Oracle Database 11g Release 2. В качестве операционной системы возьмем Oracle Enterprise Linux 5. Oracle Enterprise Linux — операционная система, базирующаяся на RedHat Enterprise Linux. Ее основные отличия — цена лицензии, техническая поддержка от Oracle и дополнительные пакеты, которые могут использоваться приложениями Oracle.

Подготовка ОС к установке Oracle стандартна и заключается в создании пользователей и групп, задании переменных окружения и параметров ядра. Параметры для конкретной версии ОС и БД можно найти в Installation Guide, который поставляется вместе с дистрибутивом.

На узлах должен быть настроен доступ к внешним общим дискам, на которых будут храниться файлы базы данных и файлы Oracle Clusterware. К последним относятся votingdisk (файл, определяющий участников кластера) и Oracle Cluster Registry (содержит конфигурационную информацию — например, какие экземпляры и сервисы запущены на конкретном узле). Рекомендуется создавать нечетное количество votingdisk. Для создания и настройки ASMдисков желательно использовать ASMLib, которую надо установить на всех узлах:

rpm -Uvh oracleasm-2.6.9-55.0.12.ELsmp-2.0.3-1.x86_64.rpm

Кроме интерфейса для взаимодействия с хранилищем на узлах желательно настроить три сети — Interconnect, External и Backup.

Необходимо настроить IP-адресацию (вручную или с использованием Oracl e GNS) и DNS для разрешения всех имен (или только GNS).

Вначале осуществляется установка Grid Infrastructure. Для этого загружаем и распаковываем дистрибутив, затем запускаем установщик. В процессе установки необходимо указать имя кластера; указать узлы, которые будут входить в кластер; указать назначение сетевых интерфейсов; настроить хранилище.

В конце нужно выполнить с правами root скрипты orainstRoot.sh и root.sh. Первым на всех узлах выполняется скрипт orainstRoot.sh, причем запуск на следующем узле осуществляется только после завершения работы скрипта на предыдущем. После выполнения orainstRoot.sh последовательно на каждом узле выполняется root.sh. Проверить успешность установки можно с помощью команды:

Выполнив проверку, можно приступать к установке базы данных. Для этого запускаем Oracle Universal installer, который используется и для обычной установки базы.

Кроме active/active-кластера в версии 11g R2 существуют две возможности для создания active/passive-кластера. Одна из них — Oracle RACOneNode. Другой вариант не требует лицензии для RAC и реализуется средствами Oracle Clusterware. В этом случае вначале создается общее хранилище; затем устанавливается Grid Infrastructure, с использованием ASM_CRS и SCAN; а после этого на узлы устанавливается база данных в варианте Standalone. Далее создаются ресурсы и скрипты, которые позволяют запускать экземпляр на другом узле в случае недоступности первого.

Возможности в балансировке сетевой нагрузки

NLB включает следующие возможности.

Масштабируемость

Масштабируемость показывает, насколько можно расширить возможности компьютера, службы или приложения в соответствии с повышением требований к его производительности. Применительно к кластерам NLB масштабируемость — это возможность добавления одной или нескольких систем к существующему кластеру, когда общая нагрузка кластера превышает его текущую производительность. Поддержка масштабируемости реализуется в средстве балансировки сетевой нагрузки следующим образом.

- Балансировка запросов нагрузки в пределах NLB-кластера для отдельных служб TCP/IP.

- Поддержка до 32 компьютеров в одном кластере.

- Балансировка запросов нагрузки для нескольких серверов (как от одного клиента, так и от нескольких клиентов) по нескольким узлам кластера.

- Возможность добавления узлов к NLB-кластеру при возрастании нагрузки без перерыва в работе кластера.

- Возможность удаления узлов из кластера при снижении нагрузки.

- Реализация высокой производительности и снижение накладных расходов благодаря полнофункциональному конвейерному режиму. Этот режим позволяет отправлять запросы NLB-кластеру, не ожидая ответа на предыдущий запрос.

Высокая надежность

Система высокой надежности обеспечивает безотказное обслуживание на приемлемом уровне с минимальными простоями. Средство балансировки сетевой нагрузки включает встроенные компоненты, обеспечивающие высокую надежность путем автоматического выполнения следующих действий.

- Распознавание сбоя или отключения узла кластера и его восстановление.

- Балансировка нагрузки сети при добавлении и удалении узлов.

- Восстановление и перераспределение рабочей нагрузки в течение 10 секунд.

Управляемость

Имеются следующие возможности управления NLB.

- Управлять несколькими кластерами NLB и узлами кластеров и настраивать их можно с одного компьютера с помощью диспетчера NLB.

- Используя правила управления портами, можно задавать режим балансировки для отдельного IP-порта или группы портов.

- Для каждого веб-сайта можно определить особые правила для портов. Если для нескольких приложений или веб-сайтов используется один набор серверов с балансировкой нагрузки, правила для портов выбираются по виртуальному IP-адресу назначения (с использованием виртуальных кластеров).

- Все клиентские запросы можно направлять на один узел с помощью дополнительных правил одного узла. NLB будет направлять клиентские запросы на определенный узел, где выполняются заданные приложения.

- Можно заблокировать доступ по сети к определенным IP-портам.

- Для контроля переполнения коммутатора (при работе в многоадресном режиме) можно включить поддержку протокола IGMP (Internet Group Management Protocol).

- Можно запускать, останавливать действия NLB и управлять ими с любого подключенного к сети компьютера под управлением Windows при помощи команд оболочки или сценариев.

- События NLB можно просматривать в журнале событий Windows. В журнал событий записываются все действия NLB и изменения кластера.

Простота использования

В средстве NLB предусмотрен ряд функциональных возможностей для удобства его использования.

- NLB устанавливается как стандартный компонент Windows — сетевой драйвер.

- NLB не требует для запуска и работы каких-либо изменений в оборудовании.

- Диспетчер NLB позволяет создавать новые кластеры NLB.

- Диспетчер NLB позволяет управлять несколькими кластерами и всеми узлами кластеров и настраивать их с одного удаленного или локального компьютера.

-

Балансировка сетевой нагрузки дает клиентам возможность обращаться к кластеру по единому логическому интернет-имени и виртуальному IP-адресу, называемому IP-адресом кластера (сохраняются отдельные имена для каждого компьютера). NLB поддерживает несколько IP-адресов для многосетевого сервера.

Примечание В случае виртуального кластера сервер не обязательно должен быть многосетевым, чтобы иметь несколько IP-адресов.

- Средство NLB может быть привязано к нескольким сетевым адаптерам, что позволяет настроить несколько независимых кластеров на каждом узле. Поддержка нескольких сетевых адаптеров — это не то же самое, что виртуальные кластеры, в которых можно настраивать несколько кластеров на одном сетевом адаптере.

- Не требуется вносить изменения в серверные приложения, чтобы запускать их в кластере NLB.

- NLB может быть настроена так, что при сбое и последующем восстановлении работы узла он будет добавляться в кластер автоматически. Добавленный узел затем сможет вновь обрабатывать запросы к серверу от клиентов.

- Компьютеры можно отключать для профилактического обслуживания, не затрагивая операции кластера на других узлах.

3.3. Установка сертификата IP-HTTPS

Чтобы выполнить эту процедуру, вы должны быть членом локальной группы Администраторы или аналогичной.

Установка сертификата IP-HTTPS

-

На настроенном сервере удаленного доступа нажмите кнопку «Пуск», введите mmc и нажмите клавишу ВВОД. Если появится диалоговое окно контроля учетных записей, подтвердите, что отображаемое в нем действие именно то, которое требуется, и нажмите кнопку Да.

-

В консоли MMC в меню Файл выберите Добавить или удалить оснастку.

-

В диалоговом окне «Добавление или удаление оснастки » нажмите кнопку «Сертификаты», » Добавить», » Учетная запись компьютера», » Далее», » Готово» и » ОК».

-

В левой области консоли перейдите к разделу «Сертификаты (локальный компьютер)\Personal\Certificates. Щелкните правой кнопкой мыши сертификат IP-HTTPS, наведите указатель мыши на все задачи и выберите пункт «Экспорт».

-

На странице приветствия мастера экспорта сертификата нажмите кнопку Далее.

-

На странице Экспорт закрытого ключа выберите вариант Да, экспортировать закрытый ключ, а затем нажмите кнопку Далее.

-

На странице «Формат файла экспорта» щелкните «Личная информация» Exchange — PKCS #12 (). PFX), а затем нажмите кнопку «Далее».

-

На странице «Безопасность » установите флажок «Пароль «, введите пароль в поле «Пароль » и подтвердите пароль, а затем нажмите кнопку «Далее».

-

На странице «Файл для экспорта » введите имя файла сертификата и сохраните его на рабочем столе и нажмите кнопку «Далее».

-

На странице Завершение работы мастера экспорта сертификатов нажмите кнопку Готово.

-

В диалоговом окне мастера экспорта сертификатов нажмите кнопку «ОК».

-

Скопируйте сертификат на все серверы, которые должны быть членами кластера.

-

На новом сервере DirectAccess нажмите кнопку «Пуск», введите mmc и нажмите клавишу ВВОД. Если появится диалоговое окно контроля учетных записей, подтвердите, что отображаемое в нем действие именно то, которое требуется, и нажмите кнопку Да.

-

В консоли MMC в меню Файл выберите Добавить или удалить оснастку.

-

В диалоговом окне «Добавление или удаление оснастки » нажмите кнопку «Сертификаты», » Добавить», » Учетная запись компьютера», » Далее», » Готово» и » ОК».

-

В левой области консоли перейдите к разделу «Сертификаты (локальный компьютер)\Personal\Certificates. Щелкните правой кнопкой мыши узел «Сертификаты «, наведите указатель мыши на все задачи и выберите команду «Импорт».

-

На странице «Добро пожаловать в мастер импорта сертификатов » нажмите кнопку «Далее».

-

На странице «Файл для импорта » нажмите кнопку «Обзор «, чтобы найти сертификат. Выберите сертификат и нажмите кнопку «Далее».

-

На странице защиты закрытого ключа в поле «Пароль » введите пароль и нажмите кнопку «Далее».

-

На странице Хранилище сертификатов нажмите кнопку Далее.

-

На странице Завершение работы мастера импорта сертификатов нажмите кнопку Готово.

-

В диалоговом окне мастера импорта сертификатов нажмите кнопку «ОК».

-

Повторите шаги 13–22 на всех серверах, которые должны быть членами кластера.

Возможности Win2k3

Вообще говоря, одни кластеры предназначены для повышения доступности данных,

другие — для обеспечения максимальной производительности. В контексте статьи нас

будут интересовать MPP (Massive Parallel Processing) — кластеры, в

которых однотипные приложения выполняются на нескольких компьютерах, обеспечивая

масштабируемость сервисов. Существует несколько технологий, позволяющих

распределять нагрузку между несколькими серверами: перенаправление трафика,трансляция адресов, DNS Round Robin, использование специальных

программ, работающих на прикладном уровне, вроде веб-акселераторов. В

Win2k3, в отличие от Win2k, поддержка кластеризации заложена изначально и

поддерживается два типа кластеров, отличающихся приложениями и спецификой

данных:

1. Кластеры NLB (Network Load Balancing) — обеспечивают

масштабируемость и высокую доступность служб и приложений на базе протоколов TCP

и UDP, объединяя в один кластер до 32 серверов с одинаковым набором данных, на

которых выполняются одни и те же приложения. Каждый запрос выполняется как

отдельная транзакция. Применяются для работы с наборами редко изменяющихся

данных, вроде WWW, ISA, службами терминалов и другими подобными сервисами.

2. Кластеры серверов – могут объединять до восьми узлов, их главная

задача — обеспечение доступности приложений при сбое. Состоят из активных и

пассивных узлов. Пассивный узел большую часть времени простаивает, играя роль

резерва основного узла. Для отдельных приложений есть возможность настроить

несколько активных серверов, распределяя нагрузку между ними. Оба узла

подключены к единому хранилищу данных. Кластер серверов используется для работы

с большими объемами часто изменяющихся данных (почтовые, файловые и

SQL-серверы). Причем такой кластер не может состоять из узлов, работающих под

управлением различных вариантов Win2k3: Enterprise или Datacenter (версии Web и

Standart кластеры серверов не поддерживают).

В Microsoft Application Center 2000 (и только) имелся еще один вид

кластера — CLB (Component Load Balancing), предоставляющий возможность

распределения приложений COM+ между несколькими серверами.

3.7 Отключение балансировки нагрузки

Отключение балансировки нагрузки

-

На настроенном сервере DirectAccess нажмите кнопку «Пуск» и щелкните «Управление удаленным доступом». Если появится диалоговое окно контроля учетных записей, подтвердите, что отображаемое в нем действие именно то, которое требуется, и нажмите кнопку Да.

-

В консоли управления удаленным доступом щелкните Конфигурация. В области «Задачи » в разделе «Кластер с балансировкой нагрузки» щелкните «Отключить балансировку нагрузки».

-

В диалоговом окне «Отключить балансировку нагрузки » нажмите кнопку «ОК».

-

В диалоговом окне «Отключить балансировку нагрузки » нажмите кнопку «Закрыть».

эквивалентные команды Windows PowerShell

Следующие командлеты Windows PowerShell выполняют ту же функцию, что и предыдущая процедура. Вводите каждый командлет в одной строке, несмотря на то, что здесь они могут отображаться разбитыми на несколько строк из-за ограничений форматирования.

Отключение балансировки нагрузки приведет к удалению параметров удаленного доступа и параметров балансировки сетевой нагрузки (если настроено) со всех серверов, кроме сервера, с которого он выполняется. На этом сервере удаленного доступа параметры NLB будут удалены (если она настроена), но параметры удаленного доступа останутся.

При нажатии кнопки «Удалить параметры конфигурации» удален удаленный доступ и балансировка сетевой нагрузки (если они настроены) со всех серверов в развертывании.

Примечание

- Если удаленный доступ удаляется при развертывании балансировки нагрузки, все серверы остаются с DIP. Виртуальные IP-адреса удаляются. Это приводит к сбою всех маршрутов в корпоративной сети, предназначенных для IP-адресов. Это также влияет на записи DNS, которые были разрешены виртуальным IP-адресам, например имя субъекта сертификата сервера сетевых расположений. Чтобы избежать этой проблемы, отключите балансировку нагрузки, которая оставляет виртуальные IP-адреса на последнем сервере удаленного доступа, а затем удалите удаленный доступ.

- После использования командлета Set-RemoteAccessLoadBalancer для отключения балансировки нагрузки подождите 2 минуты, прежде чем запустить любой другой командлет. Это также следует сделать в любых сценариях, которые выполняют другой командлет после командлета Set-RemoteAccessLoadBalancer -disable .

- Отключение балансировки нагрузки изменяет виртуальный IP-адрес кластера на выделенный IP-адрес. В результате любая операция, которая запрашивает имя сервера, завершится сбоем до истечения срока действия кэшированного DNS-записи на сервере. Не выполняйте командлеты PowerShell удаленного доступа после отключения балансировки нагрузки до истечения срока действия кэша на сервере. Эта проблема чаще всего возникает при попытке отключить балансировку нагрузки на компьютере с другого компьютера, который находится в другом домене. Это также происходит при отключении балансировки нагрузки из консоли управления удаленным доступом и может препятствовать загрузке конфигурации. Конфигурация загружается после истечения срока действия кэша или очистки.

Для чего нужен кластер

Кластеры применяют в организациях, которым нужна круглосуточная и бесперебойная доступность сервисов и где любые перерывы в работе нежелательны и недопустимы. Или в тех случаях, когда возможен всплеск нагрузки, с которым может не справиться основной сервер, тогда ее помогут компенсировать дополнительные хосты, выполняющие обычно другие задачи. Для почтового сервера, обрабатывающего десятки и сотни тысяч писем в день, или веб-сервера, обслуживающего онлайн-магазины, использование кластеров очень желательно. Для пользователя подобная система остается полностью прозрачной – вся группа компьютеров будет выглядеть как один сервер. Использование нескольких, пусть даже более дешевых, компьютеров позволяет получить весьма существенные преимущества перед одиночным и шустрым сервером. Это равномерное распределение поступающих запросов, повышенная отказоустойчивость, так как при выходе одного элемента его нагрузку подхватывают другие системы, масштабируемость, удобное обслуживание и замена узлов кластера, а также многое другое. Выход из строя одного узла автоматически обнаруживается, и нагрузка перераспределяется, для клиента все это останется незамеченным.

Oracle Grid Infrastructure

Для работы Oracle RAC требуется Oracle Clusterware (или стороннее ПО) для объединения серверов в кластер. Для более гибкого управления ресурсами узлы такого кластера могут быть организованы в пулы (с версии 11g R2 поддерживается два варианта управления — на основании политик для пулов или, в случае их отсутствия, администратором).

Во втором релизе 11g Oracle Clusterware был объединен с ASM под общим названием Oracle Grid Infrastructure, хотя оба компонента и продолжают устанавливаться по различным путям.

Automatic Storage Management (ASM) — менеджер томов и файловая система, которые могут работать как в кластере, так и с singleinstance базой данных. ASM разбивает файлы на ASM Allocation Unit.

Размер Allocation Unit определяется параметром AU_SIZE, который задается на уровне дисковой группы и составляет 1, 2, 4, 8, 16, 32 или 64 MB. Далее Allocation Units распределяются по ASM-дискам для балансировки нагрузки или зеркалирования. Избыточность может быть реализована, как средствами ASM, так и аппаратно.

ASM-диски могут быть объединены в Failure Group (то есть группу дисков, которые могут выйти из строя одновременно — например, диски, подсоединенные к одному контролеру), при этом зеркалирование осуществляется на диски, принадлежащие разным Failure Group. При добавлении или удалении дисков ASM автоматически осуществляет разбалансировку, скорость которой задается администратором.

На ASM могут помещаться только файлы, относящиеся к базе данных Oracle, такие как управляющие и журнальные файлы, файлы данных или резервные копии RMAN. Экземпляр базы данных не может взаимодействовать напрямую с файлами, которые размещены на ASM. Для обеспечения доступа к данным дисковая группа должна быть предварительно смонтирована локальным ASM-экземпляром.

Oracle рекомендует использовать ASM в качестве решения для управления хранением данных вместо традиционных менеджеров томов, файловых систем или RAW-устройств.

Настраиваем IIS с репликацией

Кластер кластером, но без службы он смысла не имеет. Поэтому добавим IIS (Internet

Information Services). Сервер IIS входит в состав Win2k3, но, чтобы свести к

минимуму возможность атак на сервер, он по умолчанию не устанавливается.

Инсталлировать IIS можно двумя способами: посредством «Панели управления» или

мастером управления ролями данного сервера. Рассмотрим первый. Переходим в

«Панель управления – Установка и удаление программ» (Control Panel — Add or

Remove Programs), выбираем «Установку компонентов Windows» (Add/Remove Windows

Components). Теперь переходим в пункт «Сервер приложений» и отмечаем в «Службах

IIS» все, что необходимо. По умолчанию рабочим каталогом сервера является \Inetpub\wwwroot.

После установки IIS может выводить статические документы.

Вот, собственно, и все. Если в файл hosts, который находится в C:\Windows\System32\Drivers\Etc,

добавить запись для разрешения имени веб-сервера и IP-адрес кластера, то,

обратившись с локального узла, можно получить документ с веб-сервера. Для

репликации данных между узлами кластера используй службу DFS, о которой подробно

говорилось в последнем

номере за прошлый год.

Cluster Parameters

- Cluster MAC Address is generated automatically by using the Cluster IP Address and it’s unique across the subnet.

- Remote Control won’t work if IPSEC is enabled. Remote control uses 1717 and 2504 on port over UDP.

- Priority Unique Host ID: Lowest number is the highest — The host with this priority handles all the incoming traffic that’s not covered by Port Rules.

If a cluster node is joined with the same priority, it’s not accepted as the part of the cluster but other nodes will continue to operate. This is called the Default Host. If Default Host fails, the other node with higher priority can act as a Default Host. - Dedicated IP Address must be entered first in TCP/IP Property. It can’t be DHCP enabled. This same applies to VIP also.

- You can’t add more than 32 Port Rules to one cluster and it must be same across the cluster.

Network Load Balancing Manager

-

You can’t open any network property for the host if NLB Manager currently uses this.

-

NLB can be configured for any machine as long as you have administrative rights on the remote computer.

-

To configure NLB successfully on Windows 2003, use the NLB Manager — Make sure you’ve unchecked the NLB from all hosts.

-

When you add a host using NLB Manager the Port Rules and associated options will be inherited from the initial host.

-

You can’t open other hosts from the NLB Manager if NLB is operating in Single Adapter with Unicast Mode because a single network adapter with unicast mode can’t have intrahost communication. To make this happen, use this registry: UnicastHostInterCommSupport and set it to 1.

-

You can use the Credentials Option in NLB Manager to specify the credentials for remote hosts. NLB Manager will try to connect to remote hosts using this credential.

-

You should use either TCP/IP Property settings or NLB Manager but shouldn’t use both to configure NLB.

-

NLB Manager doesn’t connect or show the mis-configured Hosts in a cluster.

-

Hosts for which you don’t have administrative membership won’t be displayed in NLB Manager.

-

The list of all port ranges is sorted by Port Range.

-

NLB can have mixed of Domain Controllers, Member Servers, Workgroup servers, and so on. This isn’t the limitation of NLB actually. NLB should be able to access the computer using the built-in administrator account.

-

When you enable NLB on a server, the default registry entries are created under:

-

The DIP and VIP must be entered correctly. The cluster nodes will converge with each other if you omit this step but they won’t be able to accept and traffic.

-

IP Address conflict message is displayed for VIP only. Make sure VIP from all adapters is removed if you uncheck NLB on that host.

-

The following tools can be used with NLB for monitoring:

- ClusterSenitel

- Data Warehouse Center

- HTTPMon — for monitoring IIS Services.

- MOM

-

When load balancing PPTP requests, the two network adapters are required on each NLB host.

-

You should supply gateway address in TCP/IP property when configuring two network adapters. The gateway should be entered to FE NIC.

-

NLB must be enabled on the Public or Internet facing network adapter.

-

Loading Balancing a telnet connection requires the associated ports to be opened. A telnet connection spans only one connection per IP so affinity isn’t required in this case.

-

The original implementation of NLB is WLBS. All the events are recorded in the source of WLBS. The command-line interface for NLB is WLBS and in Windows 2003, it’s NLB.

-

NLB Manager WMI provider can’t connect to a cluster host for which the computer name starts with a numeric character. This is bug.

-

NLB doesn’t replicate the application data. You might need to use the Microsoft content Replication System (CRS) or third-party software.

-

NLB doesn’t monitor the services stop or start also. You can use HTTPMon that comes with Resource kit. You can use the following tools described below:

-

Exception Monitor

-

HTTPMon

-

Third-party monitoring tools

- SiteScope by Mercury Interactive Corporation

- AppManager by NetIQ

- WhatsUp Gold by Ipswitch

-

Одноадресной рассылки

Одноадресная рассылка — это самый простой режим операции для настройки. Теоретически вам не нужно ничего делать в сетевой инфраструктуре. Фактически может потребоваться изменить инфраструктуру для управления сетевым трафиком.

В одноадресном режиме NLB использует MAC-адрес сетевой подсистемы балансировки нагрузки для замены исходного АППАРАТНОГО MAC-адреса каждого адаптера в каждом узле кластера. Так как несколько адаптеров теперь имеют один и тот же адрес, все физические коммутаторы в сети больше не могут правильно поддерживать свои таблицы MAC-адресов. Так как они не могут определить, какой трафик проходит через порт коммутатора, коммутаторы начинают отправлять весь трафик на все порты, чтобы убедиться, что трафик достигает места назначения. Это называется одноадресным сценарием переполнения.

Одноадресное переполнение может серьезно повлиять на производительность сети. Помимо обычного сетевого трафика каждый узел сетевой подсистемы балансировки нагрузки отправляет пакеты пульса (каждый пакет пульса содержит около 1500 байт данных). По умолчанию узел отправляет пакет пульса каждую секунду и ожидает получения пяти из этих пакетов, пока узел не будет считаться конвергентным. В ситуации одноадресного переполнения все коммутаторы перенаправлены этот трафик пульса на все порты коммутатора так же, как обычный сетевой трафик. Например, если сеть имеет 24-порт или 48-портный коммутатор и только два из этих портов подключаются к узлам балансировки сетевой нагрузки, коммутатор может в итоге транслировать значительный сетевой трафик на 22 (или 46) серверах, которым он не нужен.

Чтобы избежать одноадресного переполнения, доступны следующие варианты:

-

Вариант 1. Вставка концентратора между сетевым коммутатором и узлами балансировки сетевой нагрузки. Концентратор использует ОДНОадресный MAC-адрес сетевой подсистемы балансировки нагрузки и подключается к одному порту коммутатора, что позволяет коммутатору правильно управлять таблицей MAC-адресов. Концентратор перенаправлять трафик на узлы NLB, а серверы, подключаемые к другим портам коммутатора, не получают дополнительный трафик NLB.

-

Вариант 2. Создайте отдельную виртуальную ЛС для NLB-серверов. Убедитесь, что другие подсети могут получить доступ к виртуальной локальной сети. Эта конфигурация изолирует трафик NLB к портам коммутатора, назначенным этой виртуальной локальной сети.

Настройка компьютеров с двумя сетевыми картами в одноадресном режиме

В некоторых случаях на компьютере требуется две сетевые карты. Если вы используете Windows Server 2008 или более поздней версии, необходимо включить IP-пересылку на сетевых адаптерах, чтобы обеспечить правильную маршрутизацию трафика. IP-пересылка включена по умолчанию в более ранних версиях Windows.

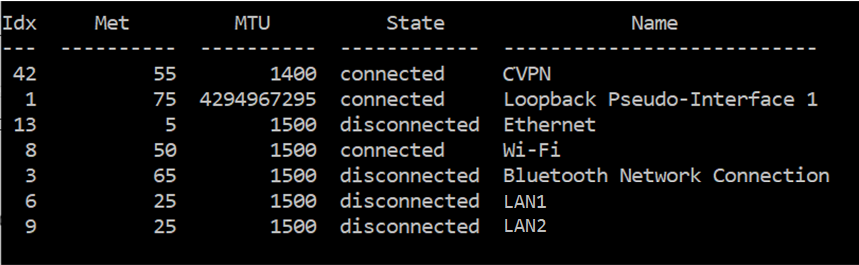

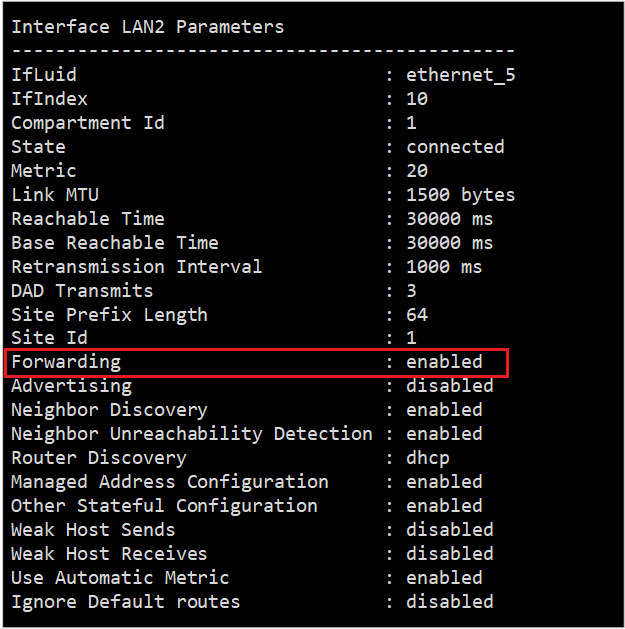

Перед включением IP-пересылки необходимо получить индекс сетевого адаптера кластера. На компьютере, который необходимо настроить, откройте окно командной строки и выполните следующую команду:

В выходных данных этой команды перечислены интерфейсы на компьютере, как показано ниже.

В окне командной строки выполните следующую команду:

В этой команде идентификатор <кластера> представляет индекс интерфейса кластера.

Чтобы убедиться, что параметр изменился, выполните следующую команду:

В этой команде идентификатор <кластера> представляет индекс интерфейса кластера.

Выходные данные показывают, что переадресация включена.

Настройка виртуальных сред в одноадресном режиме

По умолчанию виртуальные коммутаторы в виртуальных средах обычно предотвращают одноадресное переполнение. Дополнительные сведения о конфигурации см. в следующих ресурсах:

-

Если вы используете Hyper-V для запуска виртуальной среды, откройте консоль управления Hyper-V. Выберите параметры виртуальной машины, выберите параметры сетевой карты, а затем выберите «Включить спуфинг MAC-адресов». Нажмите кнопку ОК. Дополнительные сведения см. в разделе «Совет. Настройка спуфинга MAC-адресов для виртуальная сеть адаптеров».

-

Если вы используете VMware для запуска виртуальной среды, обратитесь к статье VMware о неправильной работе сетевой подсистемы балансировки нагрузки (Майкрософт) в одноадресном режиме (1556). В этой статье объясняется, как настроить инфраструктуру виртуальной сети. Не забудьте обратиться к VMware, если у вас есть вопросы об их документации.

-

Если вы используете другую виртуальную среду (например, XenServer или VirtualBox) и у вас возникают аналогичные проблемы, обратитесь к производителю за рекомендациями.

![Cisco apic layer 3 networking configuration guide, release 4.1(x) - microsoft nlb [cisco application policy infrastructure controller (apic)] - cisco](http://robotrackkursk.ru/wp-content/uploads/9/f/6/9f6787f75d8f152aba29ce90380d4915.jpeg)